Test • GeFORCE GTX 1070 Ti |

————— 02 Novembre 2017

Test • GeFORCE GTX 1070 Ti |

————— 02 Novembre 2017

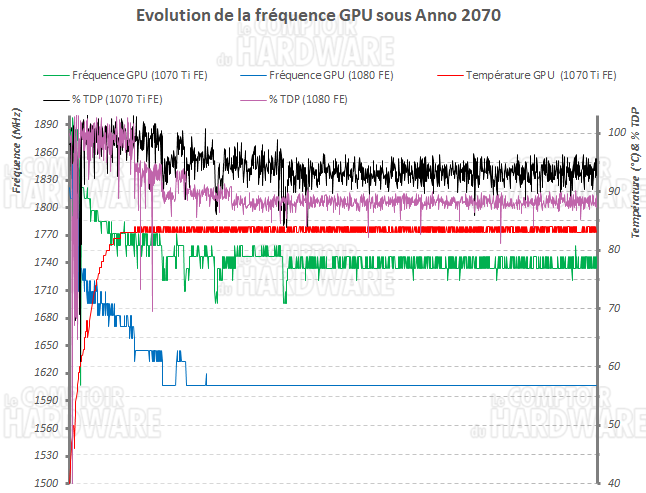

Pour jauger l'ampleur des éventuelles baisses de fréquences induites par les limites de température et consommation imposées à la GTX 1070 Ti FE via GPU Boost 3.0, nous avons mesuré la fréquence de son GPU en tâche de fond sous forte charge (Anno 2070 en QHD), soutenue durant 30 min :

L'évolution de la fréquence GPU de la GTX 1070 Ti FE sous forte charge

Malgré un TDP en hausse notable par rapport à la GTX 1070, la version Ti s'avère limitée par ce dernier durant les premières minutes du test, jusqu'à ce que la température joue son rôle limitant, à partir de 82°C. La fréquence du GPU baisse progressivement sous l'effet de ces deux contraintes, pour se stabiliser entre 1733 et 1746 MHz. En poussant le test durant une heure, nous obtenons une fréquence moyenne de 1742 MHz, soit 60 MHz de plus que le Boost annoncé, nous disposons donc d'un "bon" exemplaire.

Sur le même test et dans les mêmes conditions, notre 1080 FE se retrouve avec un déficit de fréquence moyenne à pratiquement 130 MHz, avec 1614 MHz. Point remarquable, elle a plus de mal à s'approcher de sa limite de consommation que la nouvelle venue. Cette dernière profitant à priori des progrès du procédé de gravure 16 nm de TSMC depuis la commercialisation des GTX 1070/1080, il y a de cela 18 mois. Un exemplaire plus récent devrait probablement se comporter mieux que notre sample, cela explique la proximité des 2 cartes lors de notre test.

Pour rappel ce comportement n'est en rien un défaut, c'est ce qui est recherché par NVIDIA pour soigner l'efficacité de sa puce et la garder sous contrôle, ce mécanisme permettant de s'affranchir des marges de sécurité que prenaient auparavant les concepteurs de GPU, pour valider les fréquences de fonctionnement dans toutes les conditions de leurs GPU. Cela permet ainsi un gain de performance lorsque les conditions sont plus favorables (charge 3D moins lourde, conditions climatiques plus clémentes, etc.), mais induit plus de variabilité.

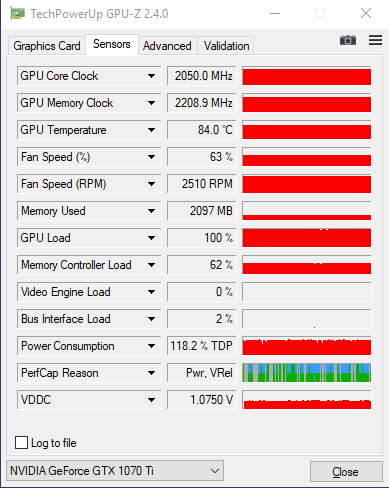

Nous venons de le voir, la GTX 1070 Ti FE est une carte limitée par sa consommation maximale autorisée ainsi que la température. Dans ces conditions, est-il possible d'en tirer davantage par overclocking ? Chez les verts, cette opération est toujours bénéfique car elle consiste à appliquer un offset au niveau de la courbe tension/fréquence. De quoi améliorer l'efficience, mais on peut aller encore plus loin en autorisant des limites de température et consommation plus élevées, limitant ainsi la baisse de fréquence du fait de GPU Boost, mais au détriment de l'efficacité cette fois ! Pour cette opération, nous utilisons la dernière version d'eVGA Precision XOC, sans souci notable.

GeFORCE GTX 1070 Ti FE overclockée

Au final nous avons réussi à grignoter un peu plus de 17% pour le GPU et 10% côté mémoire, de quoi gagner un peu moins de 12% sous The Witcher III, pour une consommation en hausse de 39 W et des nuisances sonores plus élevées de 4,4 dBA. Page suivante, passons aux mesures de bruit et températures.

|

|

| Un poil avant ?Afterburner 4.4.0 est en version finale/stable | Un peu plus tard ...EPYC 2 serait-il un monstre ? |  |