Test • GeFORCE GTX Titan |

————— 13 Mars 2013

Test • GeFORCE GTX Titan |

————— 13 Mars 2013

Comme nous l'évoquions en débutant ce dossier, NVIDIA a déjà étrenné son GPU GK110 au travers de la gamme Tesla via les K20 et K20X. Si l'on se réfère à l'historique des nomenclatures du caméléon, la seconde lettre détermine l'architecture (F pour Fermi des GF1xx, K pour Kepler des GK1xx) le troisième chiffre détermine quant à lui le segment de la puce : 0 pour le haut de gamme, 4 pour le segment Performance, 6 pour Mainstream et 7 pour l'entrée de gamme. Le second chiffre sert lui à différencier les révisions d'une même puce (GF110 = GF 100 révisé). On se doute donc qu'avec le code GK110, cette puce ne vise rien d'autre que la performance à tous les niveaux. Fidèle à son habitude, NVIDIA a conçu un GPU très imposant pour cette gamme puisqu'il occupe une superficie de pas de moins de 561 mm² :

GK110, un très gros GPU !

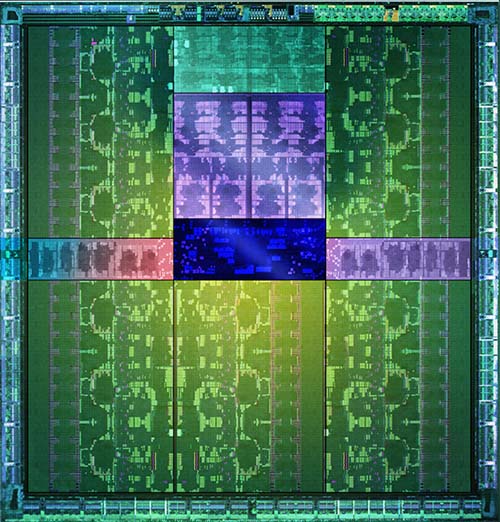

Pour autant, ce n'est pas là le record du caméléon puisque pour mémoire le GT200 qui animait la GTX 280 occupait une surface de die de 576 mm² soit la plus grosse puce jamais produite par NVIDIA et TSMC, à l'époque en 65 nm, ce qui explique sa densité en transistors (1,4 milliard) relativement faible en comparaison de celle de GK110 qui lui en emploie 7,1 milliards via le procédé de fabrication 28 nm... Reste que l'on est ici sur des superficies gigantesques ce qui complexifie très largement la fabrication, augmente les coûts (moins de GPU par Wafer (disque de silicium sur lequel sont gravées les puces) et abaisse donc les rendements (Yields) avec de nombreuses puces partiellement défectueuses. En contrepartie cela donne un beau bébé surtout lorsqu'il est retouché artistiquement pour la communication comme l'image ci-dessous :

Miroir, ô miroir, qui est le plus beau gros ?

Qu'a donc mijoté le caméléon pour nous pondre pareil monstre ? Tout d'abord, l'architecture utilisée, Kepler, est pour rappel un dérivé de Fermi retravaillé pour offrir une efficacité énergétique bien supérieure. Nous n'allons pas re-détailler cette dernière, pour ceux intéressés par le sujet, direction notre dossier GTX 680. Alors que GK104 emploie 4 GPC (Graphics Processing Clusters) constitués chacun de 2 SMX (Streaming Multiprocessors) et d'un rasterizer, GK110 s'articule lui autour de 5 GPC eux-mêmes comprenant 3 SMX, mais toujours un seul rasterizer.

Au final on se retrouve donc (à fréquence égale) avec une puissance de calcul presque doublée, mais un débit en pixels limité par un gain de 25% "seulement" du fait du nombre de rasterizer... Enfin, le bus mémoire croît de son côté de 50% avec 2 contrôleurs 64-bit additionnels par rapport au GK104 et donc une largeur de bus totale à 384-bit. 8 ROP étant toujours associés à chaque contrôleur, on obtient pour ces derniers le nombre de 48. Et schématiquement ça donne quoi ?

![Visionner en grand sur un magnifique pop-up Schéma GK110 [cliquer pour agrandir]](/images/stories/articles/gpu/gtx_titan/img/schema_gk110_t.jpg)

Le schéma de principe du GK110 - Cliquer pour agrandir

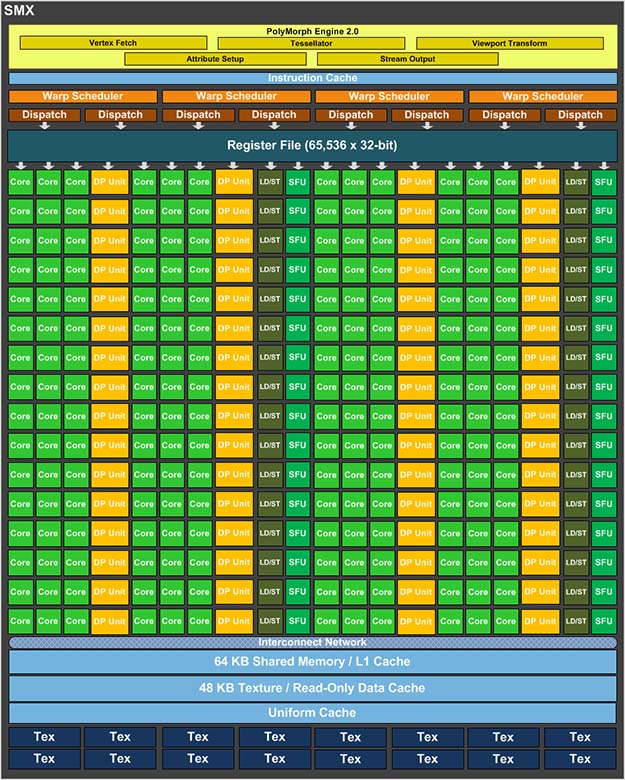

Vue de détail d'un SMX cette fois, on retrouve bien sûr le Polymorph Engine dans sa seconde révision qui fait toute la force des GeFORCE dans le traitement de la géométrie (intégralement découplée) avec (dans le cas de GK110) pas moins de 7,5 triangles par cycle ! Les 192 Cuda Cores (unités de calculs) par SMX sont toujours présents, mais à ces derniers s'ajoutent 64 unités dédiées à la double précision permettant de corriger ce point faible avéré de GK104 dans le GPU computing. Notons que sur GTX Titan, leur activation se fait par le biais des pilotes et a pour conséquence la désactivation de GPU Boost. Enfin, les 16 TMU sont toujours présentes par SMX.

Composition d'un SMX du GK110

En faisant les comptes, on obtient donc pour le GK110 la bagatelle de 2880 unités de calcul, 240 TMU, 48 ROP et 15 Polymorph Engine. Toutefois, la complexité de la puce est telle que le caméléon (probablement afin de conserver des rendements acceptables) a dû se résoudre à désactiver un SMX par GK110 pour le moment, ce qui porte les valeurs respectives à 2688, 224, 48 et 14.

Dernière petite spécificité sur laquelle communique NVIDIA : GPU Boost passe en version 2. En pratique ce "turbo" automatique permet aux cartes du caméléon d'obtenir une fréquence de fonctionnement plus élevée lorsque le TDP n'est pas atteint. La seconde révision ajouterait une nouvelle composante à savoir la température. En fait, cela permettrait de valider des tensions d'alimentation GPU plus élevées afin de gagner encore en fréquence, pourvu que la température de fonctionnement n'excède pas la valeur fixée par NVIDIA. Ici, il s'agit de 80°C, difficile pour autant de croire qu'auparavant la température n'était pas surveillée. La valeur de cette dernière étant probablement plus élevée en fait, bref difficile de parler de réelle nouveauté et encore plus de gain pour l'utilisateur, comme vous allez le découvrir page suivante lors du descriptif de la carte : à moins de modifier son système de refroidissement, GPU Boost 2.0 agit davantage comme un "limitateur" des performances par rapport à la première version, qui disposait à priori de davantage de marge quant à la température autorisée...

Dernière petite spécificité sur laquelle communique NVIDIA : GPU Boost passe en version 2. En pratique ce "turbo" automatique permet aux cartes du caméléon d'obtenir une fréquence de fonctionnement plus élevée lorsque le TDP n'est pas atteint. La seconde révision ajouterait une nouvelle composante à savoir la température. En fait, cela permettrait de valider des tensions d'alimentation GPU plus élevées afin de gagner encore en fréquence, pourvu que la température de fonctionnement n'excède pas la valeur fixée par NVIDIA. Ici, il s'agit de 80°C, difficile pour autant de croire qu'auparavant la température n'était pas surveillée. La valeur de cette dernière étant probablement plus élevée en fait, bref difficile de parler de réelle nouveauté et encore plus de gain pour l'utilisateur, comme vous allez le découvrir page suivante lors du descriptif de la carte : à moins de modifier son système de refroidissement, GPU Boost 2.0 agit davantage comme un "limitateur" des performances par rapport à la première version, qui disposait à priori de davantage de marge quant à la température autorisée...

|

|

| Un poil avant ?La GTX Titan iChill d'Inno3D | Un peu plus tard ...Western Digital investit massivement sur le SSD |  |