Le marché des serveurs affiche une croissance soutenue, avec une place croissante des ASIC |

————— 21 Janvier 2026 à 15h15 —— 12328 vues

Le marché des serveurs affiche une croissance soutenue, avec une place croissante des ASIC |

————— 21 Janvier 2026 à 15h15 —— 12328 vues

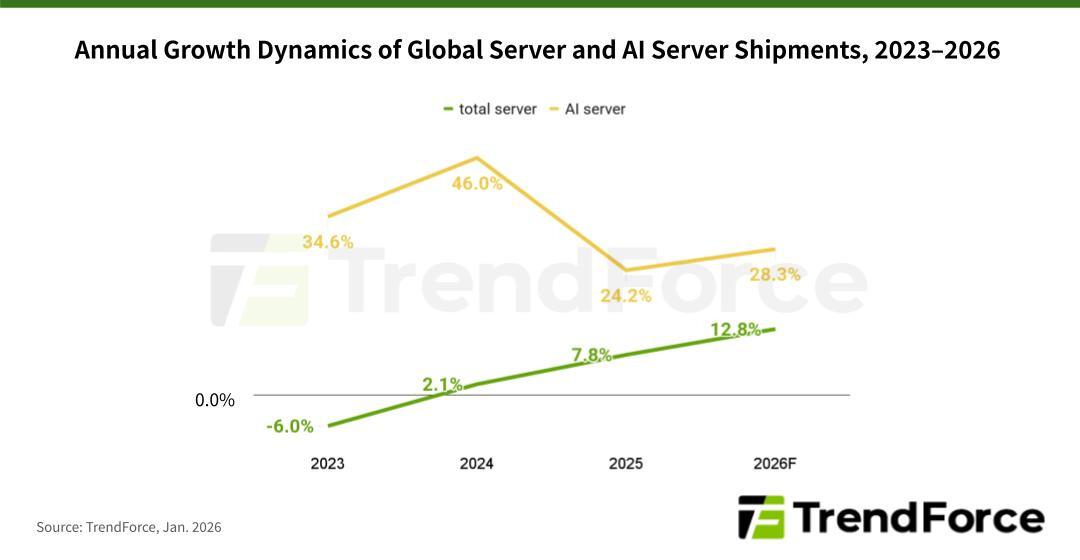

Nous voyons déjà l’incidence de l’engouement pour les infrastructures d’IA sur le prix de nos chers composants. Un rapport de TrendForce met en lumière les dynamiques à l’œuvre en coulisses chez les CSP nord-américains (CSP = Cloud Service Provider). Le document indique que leurs investissements continus dans les infrastructures d’IA devraient entraîner une hausse de plus de 28 % en glissement annuel des expéditions mondiales de serveurs d’IA. À l’échelle mondiale, tous types de serveurs confondus, le cabinet anticipe une progression de 12,8 % sur un an en 2026.

Restons sur le marché des serveurs d’IA. TrendForce estime qu’en 2026, « la croissance des expéditions devrait provenir principalement des CSP nord-américains, des projets de cloud souverain gouvernementaux, ainsi que du développement accru de solutions d’inférence IA en périphérie et d’ASIC conçus en interne par les grands CSP ».

Ainsi, le document met en évidence une évolution structurelle du marché. En 2024 et 2025, l’essentiel des investissements serveur a été capté par l’entraînement des LLM, au travers d’infrastructures d’IA lourdes, bâties autour de GPU et de HBM, taillées pour le calcul massivement parallèle. Ce paysage a commencé à se transformer au second semestre 2025, avec la généralisation des agents d’IA, la diffusion d’applications reposant sur LLaMA et les évolutions successives de Copilot. Autant de dynamiques qui ont poussé les CSP à déplacer le curseur vers l’inférence, laquelle serait « devenue un enjeu économique à part entière ».

Forcément, cette bascule se traduit aussi sur le plan matériel. Le rapport précise que « les charges de travail d’inférence en IA ne sont désormais plus cantonnées à des racks de serveurs d’IA dédiés, mais sont également déployées sur des serveurs généralistes, chargés des opérations de pré- et post-inférence, ainsi que du stockage ».

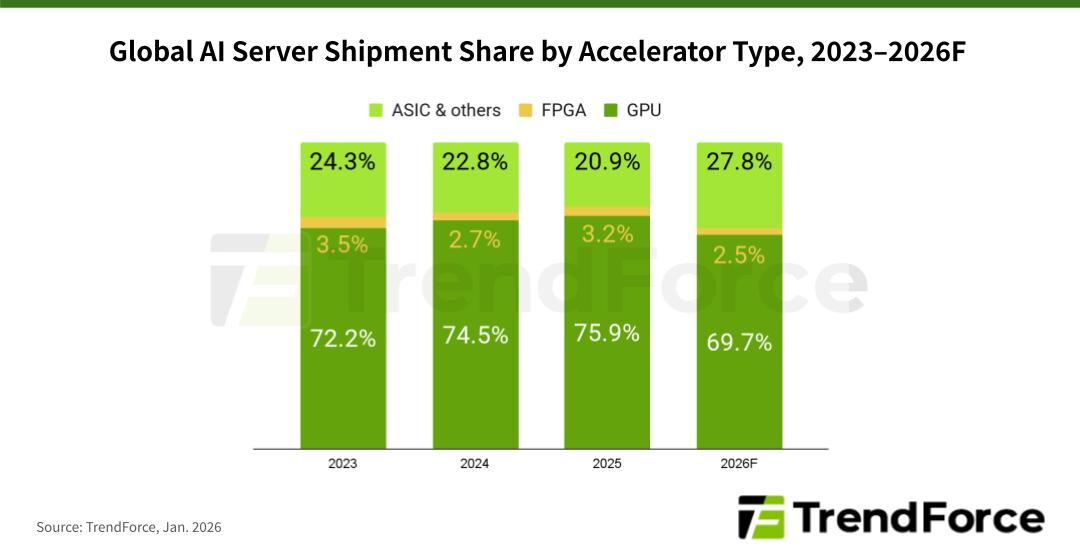

En matière de répartition, les GPU conserveront leur position dominante en 2026 : ils devraient représenter 69,7 % des livraisons. Les GB300 de NVIDIA constitueraient l’essentiel des volumes, tandis que les plateformes basées sur VR200 (Vera-Rubin) sont appelées à gagner progressivement du terrain au cours du second semestre.

Cependant, en parallèle, la part des serveurs d’IA fondés sur des ASIC devrait atteindre 27,8 % en 2026, soit son plus haut niveau depuis 2023. TrendForce explique ce regain par les efforts d’acteurs, en particulier de Google et Meta, pour pousser leurs puces propriétaires. En la matière, le géant de Mountain View ferait figure de proue avec ses TPU (Tensor Processing Units). Ces accélérateurs conçus en interne, qui alimentent Google Cloud Platform, seraient de plus en plus proposés à des clients externes, tels qu’Anthropic. Résultat : les livraisons de serveurs d’IA à base d’ASIC sont amenées à croître plus rapidement que celles des systèmes reposant sur des GPU.

Enfin, toujours selon TrendForce, les dépenses d’investissement cumulées des cinq grands CSP nord-américains — Google, AWS, Meta, Microsoft et Oracle — devraient bondir de 40 % sur un an en 2026. Au-delà du déploiement de nouvelles infrastructures, le rapport met en avant le renouvellement des serveurs généralistes installés lors de la vague d’investissements cloud de 2019 à 2021. Il souligne également le rôle moteur de Google et Microsoft, toutes deux appelées à renforcer leurs parcs de serveurs afin d’absorber le flux massif de requêtes d’inférence généré quotidiennement par Gemini et Copilot.

| Un poil avant ?Intel s’offre Eric Demers, pointure du GPU | Un peu plus tard ...AMD déploie son AI Bundle pour démocratiser l’IA locale |  |