Google dope Bard à coups de Gemini : vers la fin de l'omniscience de ChatGPT ? (MAJ) |

————— 08 Décembre 2023 à 12h15 —— 40466 vues

Google dope Bard à coups de Gemini : vers la fin de l'omniscience de ChatGPT ? (MAJ) |

————— 08 Décembre 2023 à 12h15 —— 40466 vues

Google’s Gemini recently made waves as a major competitor to OpenAI’s GPT. Exciting! But we wondered:

— Graham Neubig (@gneubig) December 19, 2023

How good is Gemini really?

At CMU, we performed an impartial, in-depth, and reproducible study comparing Gemini, GPT, and Mixtral.

Paper: https://t.co/S3T7ediQLa

???? pic.twitter.com/NmEOeDd8pI

Dans une démo Youtubisée assez impressionnante, Google vient d'afficher ses ambitions en matière d'IA générative. Alors, on va se détendre tout de suite à propos de ladite vidéo : impressionnante oui, mais un poil moins si vous lisez les petites lignes : il s'agit bien d'un montage retranscrivant avec de gros raccourcis le résultat qui est montré. On est encore loin du temps réel suggéré, et la source des réponses reste bien une succession de prompts. Du bon vieux marketing comme on les aime. Si les débuts de Bard en mai 2023 n'avaient pas franchement convaincu (et ne le font d'ailleurs toujours pas à cette heure), c'était sans compter sur la toute puissance Alphabetienne qui s'agitait en coulisse pour accoucher, avant-hier 6 décembre, de Gemini, qui n'a rien d'une croquette.

Les prétentions sont sans nul doute de voler le vedette au « précurseur » ou plutôt dirons-nous au premier sorti qui n'a eu de cesse que de s'améliorer depuis, avec un GPT-4 depuis peu connecté au monde, dans un contexte de chaises musicales chez OpenAI où le grand gagnant n'est autre que Microsoft désormais partie prenante, mais non votante, sur l'entreprise. Entreprise qui dévoilait peu avant les évènements le projet Q* — pour Q star —, jalon technologique visant à aboutir sur une AGI, une intelligence artificielle générale — presque celle qui fait peur — dont les trois piliers seraient un raisonnement par arbres de pensées, un entrainement renforcé hors ligne des modèles, et une capacité d'auto-évaluation inspirée du jeu de Go en vue d'améliorer les modèles de langage.

Le cœur d'une IA, ici un pod de TPU Google v5L

Le but serait de sortir des algorithmes actuels basés sur l'auto regression pour générer du texte mot après mot, qui comme les prédicateurs de branchements sur un CPU prédit le prochain mot en se basant sur les précédents, pour aller vers des modèles utilisant la planification, consistant à ordonnancer des schémas conduisant à un objectif à partir d'une base de connaissance. Le tout pour aboutir à des capacités cognitives plus proches de celles de l'humain — en tout cas quand il en a, ce n'est pas toujours inné — et cible de perplexitude de la part des concurrents.

LA vidéo.

Revenons-y justement, au concurrent du jour. Gemini est décrit pour faire mieux sur tous les points que son meilleur ennemi, GPT-4. Et à ce jeu, la vidéo est plus qu'éloquente sur la capacité de modèle mathématique à comprendre l'environnement utilisateur et à répondre en conséquence, avec le paramètre cool en plus (il faut aller voir ailleurs si en plus vous voulez vous faire insulter). Même en gardant quelques réserves quand au montage qui nous est présenté, il y a largement de quoi alimenter les esprits complotistes sur les ambitions d'un Gemini présenté par Google comme un « assistant utile et intuitif ».

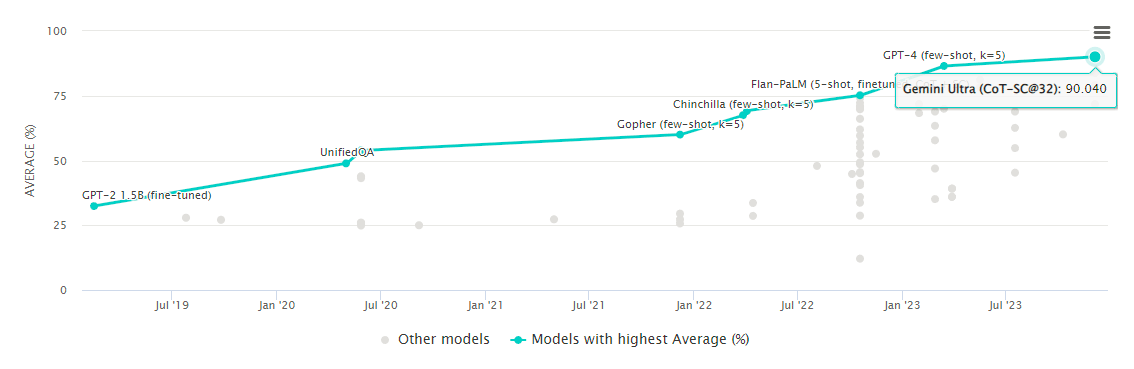

Gemini est destiné à s'inviter dans tout l'écosystème Google via trois déclinaisons de l'offre : Nano, destiné aux usages mobiles sans forcément nécessiter de connexion externe ; Pro plus polyvalent destiné à peupler les outils Google comme Bard; et Ultra, la version la plus élaborée du modèle — et évidemment celle présentée dans la vidéo. Selon Google qui documente la chose, Gemini Ultra défonce littéralement GPT-4 sur 30 des 32 métriques référents pour mesurer les capacités d'un LLM, qui progresse également sur la compréhension multitâche du langag — le fameux MMLU — en s'octroyant d'emblée la première place. Une capacité de compréhension qui du coup devrait se ressentir sur la majorité des domaines d'applications, telles que la pertinence des queries google que dans la génération de code dont les IA génératives deviennent de fiers alliés.

Gemini Ultra en tête du LLMU

L'occasion de lever le voile sur les nouveaux TPUs (oui, Tensors Processing Units) de Google, qui entrent dans leur version V5p. Au programme 459 teraFLOPS en bfloat16 ou 918 teraFLOPS en Int8, armés de 96 Go de HBM3 dotée d'une bande passante de 2,76 To/s. Pas moins de 8960 unités peuvent être déployées dans un seul cluster — ou pod —, doublant les capacités de traitement des TPU v4, base sur laquelle a été entres autres entrainé Gemini, et qui devrait prendre à minima deux fois moins de temps sur v5p, pour un coût d'exploitation légèrement supérieur.

Gemini devrait ainsi s'inviter progressivement dans les solutions Google, du moteur de recherche aux smartphones Android en passant par Chrome, courant 2024. Et devrait également arriver dans les pays de l'UE, puisqu'actuellement vous ne pouvez pas y accéder, la législation européenne opposant quelques résistances sans doute bienvenues. Cela dit avec un VPN...

| Un poil avant ?Le marché GPU tout nu tout bronzé : + 16,8 % | Un peu plus tard ...Du silicium au package: l'usine mondiale des puces électroniques |  |