Les GPU et l'IA : un couple pas si parfait à l'avenir ? |

————— 25 Septembre 2018 à 17h00 —— 17148 vues

Les GPU et l'IA : un couple pas si parfait à l'avenir ? |

————— 25 Septembre 2018 à 17h00 —— 17148 vues

En voici une nouvelle à contre-courant. Alors qu'NVIDIA roule sa bosse à la Apple avec sa gamme Turing on ne peut plus élitiste, le vent pourrait tourner. En effet, si la firme introduit actuellement deux nouvelles technologies avec les Ray Tracing Cores pour le rendu en lancer de rayons, et les Tensor Cores pour l'IA, il faut garder en tête que ces unités ont été ajoutée grâce à l'avance du géant vert sur son concurrent rouge depuis quelques générations. Cependant - et particulièrement en informatique - la roue tourne.

Si les GPU sont actuellement les rois des algorithmes de machine learning, les analystes prédisent une augmentation des solution dédiées pour les années à venir. Le compromis n'est pas nouveau : en perdant en flexibilité des unités de calcul, les performances grimpent ; certaines estimations suggèrent un facteur 100 de différence par rapport aux solutions actuelles.

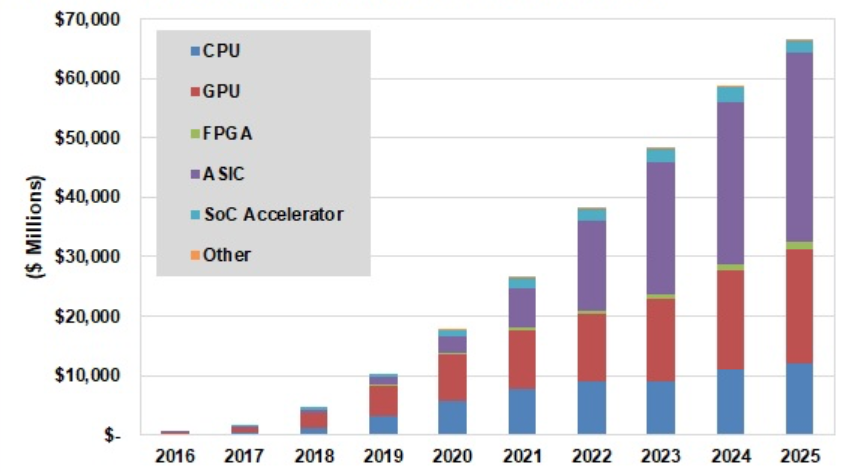

Les GPU suivent une croissance soutenue, mais perdent en part de marché relative (prévisions selon Tractica)

Depuis l'apparition des premières bases de données d'apprentissage, la puissance nécessaire pour entraîner un algorithme de machine learning sur la plus volumineuse de ces bases a doublé tous les 3,5 mois, encore pire que les fonkeries au comptoir ! Pour faire face à cette demande, on comprend donc pourquoi les ASIC - l’implémentation en dur d'un programme sur silicium - ressorte favori de cette compétition. Cependant, un autre acteur des plus discret actuellement semble un bon candidat ; les FPGA. A mi-chemin entre GPU et ASIC, ces unités logiques reprogrammables ont déjà montré leur potentiel lors des premières écumes des vagues bitcoin, avant de succomber aux ASIC, plus rentable sur une production de masse. A l'heure actuelle, leur programmation demeure des plus ardue, ce qui en fait un frein notable à son expansion.

Cela reste à prendre avec beaucoup de recul : il ne s'agit que de prévisions, et rien n'est plus dur à prédire que l'arrivée de nouvelles machines. Il se pourrait également qu'NVIDIA, fort de sa position de leader, propose par la suite des produits spécialisés IA uniquement composés de tensor cores, voire même des ASIC, histoire de se grignoter une part de lion dans les quelques 66 milliards de dollars que représenterons ce marché d'ici 2025. Pourtant les concurrents ne manquent pas : entre Intel, Google, Microsoft et moult start-up telles Wave Computing, la bataille fait rage ! (Source : SemiEngineering)

| Un poil avant ?Texas Instrument fournit plus de jus à l'USB-C | Un peu plus tard ...Chouette, la VR se fait enfin sans fil chez HTC, mais à quel prix ? |  |