GDDR6 : Micron dans les starting-blocks |

————— 05 Septembre 2018 à 20h12 —— 12683 vues

GDDR6 : Micron dans les starting-blocks |

————— 05 Septembre 2018 à 20h12 —— 12683 vues

Le lancement imminent- pas tout à fait mais on peut le considérer comme tel depuis le lancement de Pascal en mai 2016 - des Geforce RTX va permettre un premier contact de la GDDR6 avec le grand public. Son arrivée signe d'une façon ou d'une autre la mort programmée de la GDDR5 et de la GDDR5X. Nvidia avec ses RTX a choisi de la mémoire à 14 Gbps, et ce pour les 3 cartes dévoilées fin août. Question, qui a fourni le caméléon ?

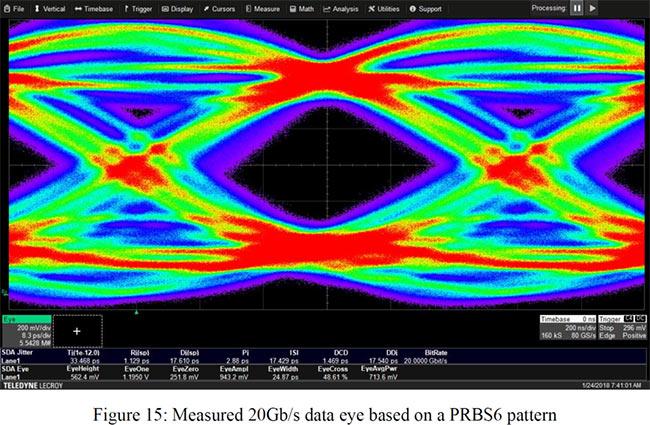

Micron a répondu présent, et c’est bien lui qui s’enorgueillit de cette prouesse, ce qui ne signifie pas que les autres n'ont pas été compétitifs. On sait juste que Micron a équipé Nvidia avec ses pupucettes. Ce n'est en soi pas une grande surprise puisque le géant avait déclaré avoir débuté la production de masse fin juin avec pas mal de puces. Voici le catalogue prévu au début. On se souvient que la firme avait aussi poussé de la GDDR6 18 Gbps à 20.5 Gbps, annonçant de ce fait des évolutions futures ? Quid de Sk Hynix et de Samsung ?

| Un poil avant ?Pour 55 boules, t'as vraiment plus rien chez AMD ? | Un peu plus tard ...Intel toujours encore à la poursuite d'un CEO |  |