Intel en dit plus sur l'iGPU Gen11 d'Ice Lake |

————— 04 Octobre 2018 à 10h49 —— 12872 vues

Intel en dit plus sur l'iGPU Gen11 d'Ice Lake |

————— 04 Octobre 2018 à 10h49 —— 12872 vues

Ice Lake devrait être la prochaine évolution architecturale majeure chez Intel qui sans les déboires du 10nm aurait d'ailleurs normalement déjà pu être parmi nous, mais celle-ci pourrait finalement ne pas arriver avant 2020 en tout cas en ce qui concerne les déclinaisons Xeon sur serveur, l'arrivée du 10nm sur le segment mainstream reste encore un mystère relativement épais.

En attendant. Ice Lake-U et sa partie graphique intégrée Gen11 se baladent régulièrement sur la toile chez Sandra, Ashes of the Singularity, ou encore HWInfo. En plus du 10nm, Ice Lake devrait justement aussi introduire la première grosse évolution de l'iGPU d'Intel depuis quatre ans et déjà connue en tant que Gen11. Elle viendrait ainsi enfin pousser à la retraite la version Gen9.5 de Skylake. Il était temps, d'autant plus que la compétition d'AMD avec ses Raven Ridge équipés en Vega est bien rude !

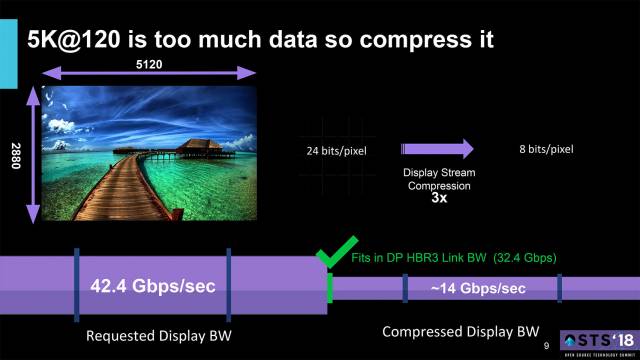

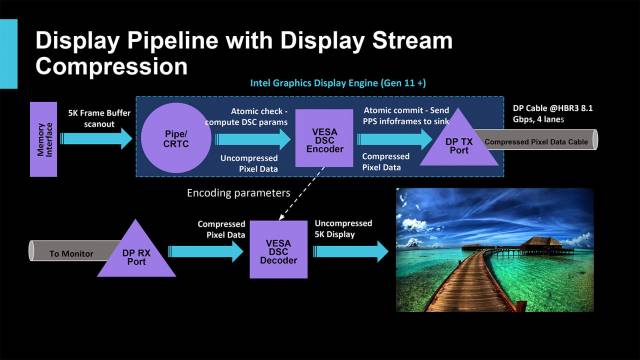

Intel en a dit un peu plus au sujet de l'iGPU Gen11 lors de la conférence XDC 2018. La compagnie confirme ainsi le support du DisplayPort 1.4a et de la fonctionnalité DSC ou Display Stream Compression de la VESA, ce qui en retour permettra à la partie graphique intégrée d’être compatible avec des définitions jusqu'à 5120 x 2880 (5K) à 120Hz. Intel nous explique qu'une telle définition serait impossible à gérer sans le DSC puisque cela nécessiterait une bande passante de 42,4Gbps, alors que le DisplayPort avec HB3 peut atteindre un maximum de 32,4Gbps seulement. L'avantage mis en avant pour le DSC est une compression garantie "sans perte de qualité perceptible" et permettant par exemple de réduire le besoin en bande passante d'un affichage 5K-120Hz à 14Gbps environ, largement dans les limites de la norme DisplayPort 1.4a. Ainsi, l'iGPU Gen11 devrait en théorie aussi pouvoir afficher du 8192 x 4320 à 60Hz.

Bien sûr, l’intérêt d'un support de telles définitions est avant tout d'accompagner les évolutions en définition et en fréquence de rafraîchissement des appareils mobiles, ordinateurs portables et des écrans, naturellement il ne faudra pas espérer pouvoir pousser du jeu en 5K ou 8K. Malheureusement, pas un mot encore sur la présence ou non de l'adaptative sync - sous-entendue récemment par Chris Hook. (Source)

| Un poil avant ?Le 10nm plus "tôt" que prévu en 2019 chez Intel ? Mouais... | Un peu plus tard ...Razer : un routeur Wi-Fi à prix d'or |  |