Une étude en cours pour optimiser les échanges CPU/GPU |

————— 08 Février 2012 à 07h57 —— 11727 vues

Une étude en cours pour optimiser les échanges CPU/GPU |

————— 08 Février 2012 à 07h57 —— 11727 vues

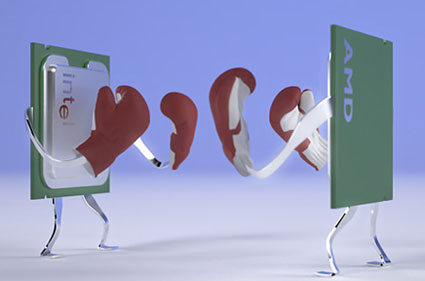

Des chercheurs à l'université North Carolina aux US, comme quoi y a pas que du basket dans ce campus, cherchent à optimiser les échanges entre CPU et GPU, mais ceux sur un même die uniquement. Le but est d'améliorer leur collaboration comme l'explique le chef de projet Dr Huiyang Zhou.

En effet selon lui, CPU et GPU travaillent chacun sur des fonctions séparées, et collaborent très peu, cela diminue leur efficacité. Le GPU, initialement bâti pour des programmes graphiques, est capable d'effectuer des fonctions individuelles très rapidement. A son inverse, le CPU a une capacité de calcul moins forte, mais est capable de traiter des tâches complexes.

L'objectif, facile à dire, est d'arriver à faire calculer au GPU des fonctions, et de permettre au CPU de précalculer d'autres fonctions dont aura besoin le GPU et de les mettre en mémoire centrale. Si le CPU est capable de déterminer quelles données en avance il peut traiter pour simplifier celui du GPU, le temps de traitement total sera réduit, et l'efficacité augmentée. Zhou estime à 21.4% le gain de performance du CPU avec cette technique. (Source TGDaily)

This is more efficient because it allows CPUs and GPUs to do what they are good at. GPUs are good at performing computations. CPUs are good at making decisions and flexible data retrieval. !

| Un poil avant ?Une HD 7900 sous XP : une bêta mais pas de WHQL | Un peu plus tard ...Nouvelle série DDR3 ARES chez G.Skill, avec rad low profile |  |