Le Tesla K40 annoncé officiellement, ainsi qu'un accord stratégique NVIDIA / IBM |

————— 21 Novembre 2013 à 19h00 —— 17357 vues

Le Tesla K40 annoncé officiellement, ainsi qu'un accord stratégique NVIDIA / IBM |

————— 21 Novembre 2013 à 19h00 —— 17357 vues

La mise à jour du Top 500 des supercalculateurs révélé lors du Supercomputing Conference de Denver ne révèle rien de nouveau puisque les trois bestiasses qui font péter le score au benchmark Linpack restent les mêmes.

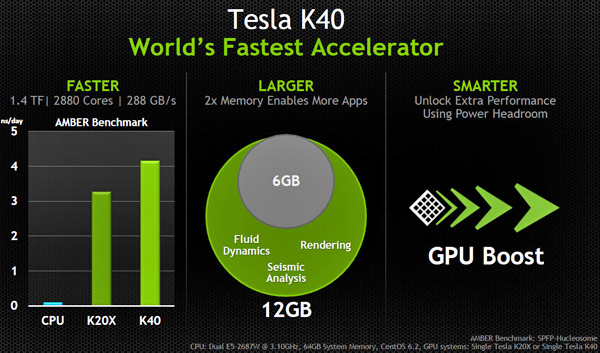

NVIDIA profite du SC13 pour officialiser le nouveau Tesla K40. Il s'agit comme prévu d'un refresh du Tesla K20X à base de GK 180, c'est à dire un full GK110. On passe donc de 2688 Cuda Cores (732 MHz) à 2880 (745 MHz). On double la capacité mémoire avec 12 Go de GDDR5 (comme la FirePro d'AMD présentée récemment), le tout contenu dans un TDP à peine 10 W supérieur à l'ancienne version (245 W) et pour des performances 20 % supérieures à 1,43 TFLOPS d'après NVIDIA.

D'autre part, la firme de Santa-Clara et IBM dévoilent un partenariat pour conjuguer la puissance et l'efficacité énergétique des Tesla et des processeurs Power8 (respectivement les plus puissants GPU et CPU dans le domaine du supercalcul). Big Blue optimisera tout son parc logiciel pour le rendre compatible avec l'accélération graphique. Ce n'est plus seulement les grands instituts scientifiques ou les organisations gouvernementales qui sont visées, mais l'objectif est bien de donner accès au calcul massivement parallèle aux entreprises. D'ailleurs, selon l'International Data Corporation, le marché du serveur professionnel, sur lequel IBM a généré 3,3 milliards de dollars de revenus au 2e trimestre, connaît un déclin important (-6,2 % sur un an au niveau global, -10 % pour IBM). Big Blue compte bien sur ce tableau également booster le marché en proposant des serveurs bien plus performants, à même de gérer d'énormes bases de données de façon beaucoup plus rapide et efficace.

l'annonce officielle du Tesla K40 par NVIDIA. le top 500 chez top500.org

| Un poil avant ?Bon plan: SSD Kingston V300 120 Go à 66,38€ livré (MAJ) | Un peu plus tard ...Intel toujours maître du marché des puces graphiques |  |