Premiers cas de fonte du connecteur d'alimentation des RTX 4090 reportés : n'a pas 450 W de TDP qui veut ! (MAJ) |

————— 25 Octobre 2022 à 11h09 —— 47347 vues

Premiers cas de fonte du connecteur d'alimentation des RTX 4090 reportés : n'a pas 450 W de TDP qui veut ! (MAJ) |

————— 25 Octobre 2022 à 11h09 —— 47347 vues

Avec la RTX 4090 et ses performances n’ayant d’égal que sa consommation, NVIDIA a frappé fort dans le cœur (et le portefeuille) des joueurs. Sauf que la carte tire tout de même la bagatelle de 450 W en charge, et étrenne de surcroit le nouveau connecteur PCIe 5.0 dont les adaptateurs ont fleuri chez les concepteurs d’alimentation. Pour être plus précis, ce connecteur physique est également compatible avec les RTX série 3000, mais en étant dépourvu d’un mécanisme de négociation de la puissance du lien : autant dire que, au mieux, la firme n’en est qu’à la seconde génération du bousin. Or, le risque principal des nouvelles technologies est de tomber sur un bug, et c'est bien ce qui semble s’être passé pour deux redditeurs (et un fesse-de-bouquin) ayant craqué pour la carte.

Une fondue de plastique pour l’hiver, ça vous dit ?

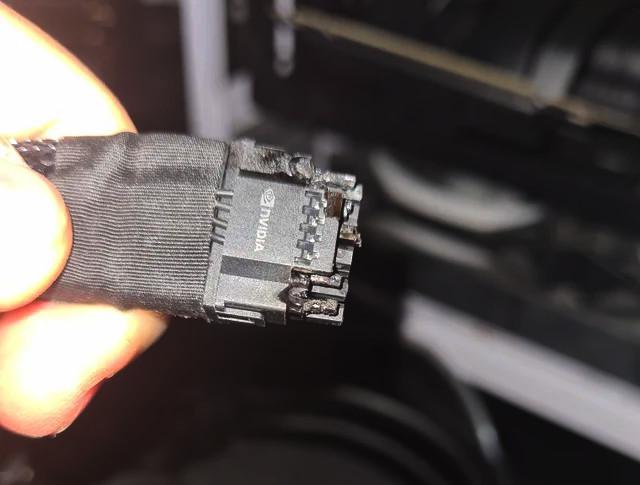

En effet, pour u/reggie_gakil et u/NoDuelsPolicy, leur rêve est rapidement parti en fumée, au sens figuré comme au sens propre, puisque le connecteur d’alimentation de la carte — ou, plus précisément, l’adapteur 4x8-pin vers 12VHPWR — a décidé de fondre sous la charge, alertant immédiatement les utilisateurs par une extinction soudaine (pour le second uniquement) et une forte odeur caractéristique (dans les deux cas). Si vous notez que, pour les deux utilisateurs, la carte fonctionne toujours - respectivement une Gigabyte RTX 4090 GAMING OC (information déduite visuellement et donc non confirmée) montée à la verticale sur une boite à jus d’électron Corsair RMx 1000 moulinant sur RDR2 et une ASUS RTX 4090 TUF OC branchée sur un Fractal Ion+2 Platinium 860 W fondant sous Black Desert —, nos malheureux joueurs verront (bien entendu !) la carte remplacée par les verts. Pour le moment, il est encore trop tôt pour savoir si le problème est limité à quelques cas isolés ou plus généraux, mais le net regorge toutefois d’informations et d’avis en tout genre sur le sujet. Décortiquons cela avec le Comptoir.

Le montage en question de u/NoDuelsPolicy

![La magie de la loupe, sans loupe Un nouveau câble parti en fumée... Suspect ! [cliquer pour agrandir]](/images/stories/_cg/lovelace/rtx-4090-fb-burnt-cable_t.jpg)

Un troisième larron serait touché, une fois de plus sur une ASUS TUF

Tout d’abord, il convient de rappeler que le connecteur n’a pas été inventé par NVIDIA mais mis au point conjointement avec le PCI-SIG, un organisme bien connu de chez nous, puisque aussi responsable des normes des liaisons PCIe, et Intel du fait de son implication dans l’établissement du standard ATX ; dans le but de remédier au « problème » que représentait la multiplication des câbles d’alimentation inhérents à la croissance de la consommation des GPU. Une solution bancale à un souci pas vraiment existant — il restait encore largement de la place sur ces GPU pour brancher davantage de câbles, d’autant plus que la fonte de câbles PCIe, ça n’est pas si nouveau — mais il faut parfois accepter les compromis, d’autant plus que les rumeurs donnaient initialement la RTX 4090 à plus de 600 W. Certes, la chose fait mal au fondement, pour une carte affichée à plus de 2000 €, mais les dernières années ont bien prouvé que le haut de gamme n’était pas forcément plus fiable que le reste — les premiers possesseurs de RTX 2080 ayant goûtés au Space Invader Bug ne diront pas le contraire, pas plus que ceux équipés de RTX 3080 aux condensateurs malheureux !

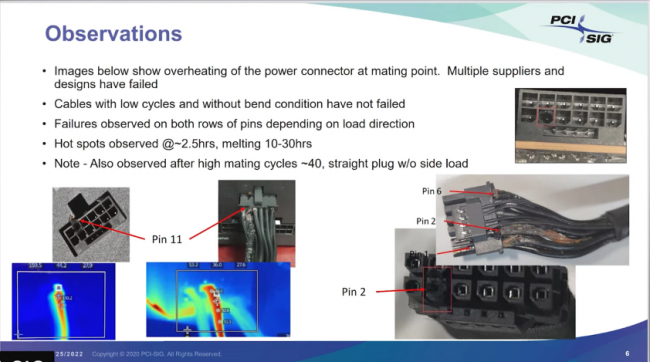

Au niveau technique, rien de bien sorcier : le connecteur étant plus fin et porteur de plus de courant, il est naturellement plus propice à la chauffe. Plus petit et relié à un tas d’autres fils, le 12VHPWR peut également plus facilement bouger de sa prise femelle, réduisant d’autant plus la surface de contact. Ce faisant, la chauffe se concentre au point de contact et, en cas d’utilisation prolongée, entraîne la décomposition de son enveloppe plastifiée. Alors comment se fait-ce que la chose n’ait pas été détectée plus tôt ? La réponse est en fait dans la question : NVIDIA avait même communiqué directement avec le PCI-SIG à ce sujet, documenté par des clichés et des analyses du problème. Notez qu’il s’agit ici d’une utilisation prolongée du connecteur sans adaptateur et de manière droite : les conditions pourtant idéales de fonctionnement ; et la brûlure était également présente côté alimentation. Selon les tests, le risque est présent une fois le fil courbé ou après une série de connexions-déconnexions importantes (plus de 40), ce qui était bien connu par cablemods, qui recommande de laisser 35 mm entre le connecteur et le début de la première torsion de son câble d’alimentation (et des verts, ayant enveloppé leur adaptateur d’une bande adhésive rigide évitant tout pliage) ; une longueur quasi impossible sans monter son GPU à 90°… ce qui n’a par ailleurs pas empêché ce dernier de monter à plus de 90 °C sur sa prise pour u/reggie_gakil !

Le PCI-SIG était lui-même informé : oups ?

Pour autant, rien n’a été fait dans la pratique, sans que nous sachions réellement pourquoi. Si un défaut des premiers exemplaires est possible, ainsi qu’une mauvaise manipulation ou interprétation des spécifications, force est de constater que le problème est arrivé jusqu’au grand public. De plus, la chose (des fontes de câbles, sans autre conséquence sur la configuration) a également été confirmée par Johnny Guru, un expert du domaine actuellement dans la R et D de chez Corsair — qui n’a rien à voir avec Johnny Lucky, en dépit de leur expertise similaire. Reste à savoir dans quelle ampleur, et dans quelles conditions. Il n’est pas impossible que les deux joueurs aient eu la main lourde sur l’overclocking et la limite de puissance (le maximum étant de 600 W, pour les deux cartes), cependant il est fortement improbable que la carte ait dépassé la spécification du connecteur, 600 W pour rappel, il y a donc un problème de… fond (ah ah).

Un peu de visionnage américain, cela vous dit ?

Cependant, une zone d’ombre demeure : dans nos tests, jamais la RTX 4090 n’a grimpé au-delà de ses 450 W. Pire, la RTX 3090 Ti lui passe systématiquement devant en matière de consommation, quel que soit le titre retenu. Pourquoi diable ne pas avoir observé de problème sur cette carte-là ? Une solution pourrait provenir de la consommation en pic, la 4090 pouvant tirer plus de 33 % à 40 % de courant au-dessus de ses spécifications sur environ une milliseconde, là où la RTX 3090 Ti montaient bien plus haut (2 à 2,5 fois le courant nominal), mais sur une durée bien plus courte de l’ordre de la microseconde. Cependant, difficile d’en tirer un lien logique, la chauffe et la fonte du plastique s’effectuant sur des temps typiques habituellement plus longs. Une autre hypothèse réside dans la pénurie, ayant entraîné moins de RTX 3090 Ti vendues et donc moins de problèmes, mais, à 10 jours de la sortie de la RTX 4090, l’explication ne colle pas plus. Vu que les cartes sont toutes deux des customs, un problème d’adaptateurs tiers n’est pas non plus à exclure : bref, difficile de se positionner avec exactitude !

En voilà davantage si vous n’êtes pas rassasiés !

En conclusion, que penser de cette affaire ? Hé bien, qu’un composant à haut TDP, ça n’est pas anodin et ça ne change pas que votre facture d’électricité — une remarque qui s’applique au passage également aux CPU. Pour les plus paranos d’entre vous (ou ceux reposants sur la carte pour une activité critique), nous ne saurions que vous conseiller de limiter la consommation de votre bébé à une valeur plus sage de 350/400 W par mesure de précaution le temps que l’histoire se règle, et de vous assurer que le connecteur est bien enfiché et l’adaptateur bien droit. Tout comme les RX VEGA en leur temps, les RTX 4090 semblent bien réagir à la chose, en ne perdant qu’une poignée de pourcents de performance au passage. Pour le reste, patience, les communiqués et démentis officiels ne devraient pas tarder à arriver ; la chose ne concernant pour le moment que trois utilisateurs !

| Un poil avant ?USB-C pour tous : le feu vert définitif a été donné ! (MAJ : Apple) | Un peu plus tard ...AIDA64 passe la vitesse 6.80 (si, c'est possible) |  |