NVIDIA dévoile Turing et les Quadro RTX, le Ray Tracing en vedette ! |

————— 14 Août 2018 à 13h00 —— 19470 vues

NVIDIA dévoile Turing et les Quadro RTX, le Ray Tracing en vedette ! |

————— 14 Août 2018 à 13h00 —— 19470 vues

Et voilà ! NVIDIA a levé le voile sur l'architecture Turing (detectée pour la premiere fois en février dernier), et Jensen étant Jensen, a qualifié celle-ci de "plus grande avancée depuis l'invention des GPU CUDA en 2006", rien de moins ! Évidemment. En plus des CUDA cores, on connaissait depuis peu aussi les tensors cores, mais il faudra désormais également compter avec les R(ay) T(racing) cores - des unités de calculs dédiées au ray tracing - et des mesures de vitesses en GigaRays/s. En ce qui concerne la visualisation professionnelle (ProViz), Turing fera donc la part belle au rendu hybride et combinera notamment le ray tracing avec la rastérisation traditionnelle afin d'exploiter les avantages des deux technologies.

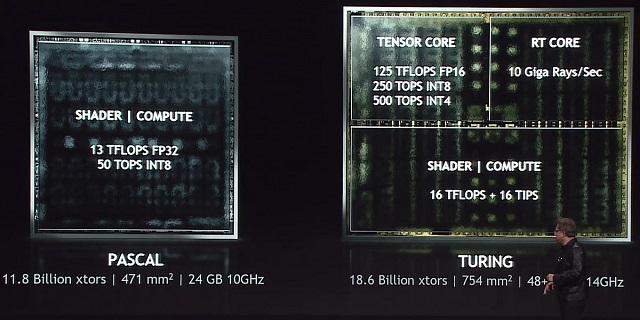

Ainsi, le couple RT et Tensor cores - de la Quadro RTX la plus rapide - est présenté par NVIDIA comme étant 25 fois plus capable pour l’accélération ray tracing en temps réel par rapport à Pascal, mais sans spécifier de modèle de GPU en particulier (toutefois certainement à base de GP102). Turing se situe donc dans la continuité de ce que NVIDIA a entamé depuis ce début d'année avec sa technologie RTX et confirme la direction prise par le constructeur sur ce terrain-là.

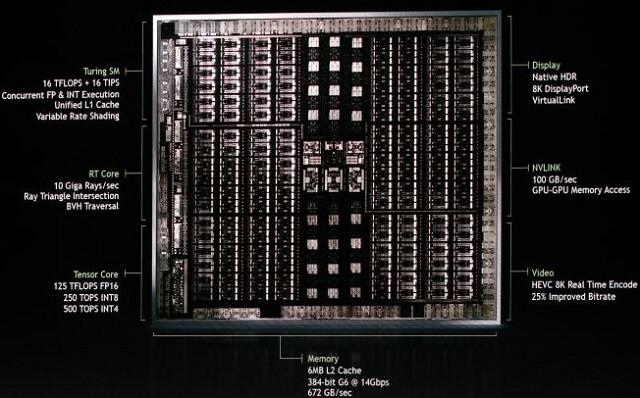

Turing, c'est aussi une nouvelle grosse puce de 18,6 milliards de transistors sur une surface de 754mm², mais dont le procédé de gravure n'a pas été dévoilé. À titre de comparaison, Pascal atteignait les 11,8 milliards sur 471mm², et le V100 de Volta en cumule 21 milliards sur 815mm². C'est donc tout de même une architecture assez imposante ! À noter que Turing intègre également une interface NVLink 100 GB/s et le support pour du HDR natif et 8K DisplayPort. À en croire les caractéristiques des premières Quadro RTX, Turing devrait offrir jusqu'à 4608 CUDA cores et des tensor cores capables d'atteindre les 125 TFLOPs en FP16, 250 TOPS en INT8 et 500 TOPS en INT4, et sans oublier jusqu'à 10 GigaRays/s avec ses RT cores. Concernant cette dernière métrique pas vraiment facile à analyser, ces 10 Gigots-raies/s représentent de quoi calculer un peu plus de 80 rayons par pixel si vous utilisez toute la surface d'un écran FullHD à 60 Hz. D'après Oui Ki Pé Dia ; un rendu reconaissable en path tracing nécessite une centaine de rayons, et on atteint l'apothéose avec plus de 5000 ; autant dire que le 100% ray tracing jouable n'est malheureusement pas pour cette génération. Bien évidemment, tous ces chiffres sont avancés par NVIDIA, à défaut de mieux en attendant de voir Turing en action IRL !

NVIDIA a aussi confirmé la compatibilité de Turing avec la GDDR6. Les premiers modèles de Quadro RTX fonctionneront avec de la GDDR6 14Gbps, la mémoire de ce type la plus rapide offerte en ce moment par les constructeurs SK Hynix, Samsung et Micron. NVIDIA a précisé qu'ils utiliseront éventuellement aussi les nouveaux modules de densité 16Gb de Samsung, laissant entrevoir la possibilité de cartes équipées de 8 modules standards pour une capacité totale de 16Go, voire 32Go en clamshell. Pour rappel, de nombreuses innovations de la GDDR6 sont en réalité déjà utilisées par la GDDR5X. Aujourd'hui, les changements majeurs apportés par la GDDR6 sont une baisse de la tension à 1,35V et une mémoire divisée en interne en deux canaux de 16-bit par puce (au lieu d'un seul de 32-bit).

Finalement, NVIDIA officialise la marque Quadro RTX (découverte il y a quelques jours en compagnie de Turing et GeFORCE RTX) et 3 nouveaux modèles de GPU : Quadro RTX 8000, RTX 6000 et RTX 5000.

| GPU | Mémoire | Ray Tracing | CUDA Cores | Tensor Cores | Dispo |

MSRP (estimation de NVIDIA) |

|---|---|---|---|---|---|---|

| Quadro RTX 8000 | 48Go | 10 GigaRays/s | 4608 | 576 | Q4 2018 | 10 000$ |

| Quadro RTX 6000 | 24Go | 4608 | 576 | 6300$ | ||

| Quadro RTX 5000 | 16Go | 6 GigaRays/s | 3072 | 384 | 2300$ |

Bref, on pouvait s'en douter, ça pique quand même pas mal. Mais en tant que 8ème génération d'architecture GPU, Turing représenterait tout de même l’équivalent d'un effort de "plus de 10 000 années d'ingénierie" si l'on en croit la sainte parole toujours très terre-à-terre de NVIDIA ! En tout cas, le constructeur semble bien vouloir tout miser en faveur de l'avenir du Ray Tracing avec sa nouvelle plateforme RTX. Pour les professionnels de l'image, les nouvelles cartes sont désormais sur la table, il nous reste maintenant à découvrir sous quelle forme se présenteront les nouvelles GeFORCE peut-être lors de la Gamescom en Allemagne, et si elles intégreront également un peu de Turing à la sauce RTX.

Par contre, en l'absence de contenu adapté pour le grand public et considérant le temps qu'il faudra certainement pour que le ray tracing se démocratise, d'hypothétiques GeFORCE RTX équipées de RT cores ne seraient ainsi probablement pas particulièrement pertinentes dans l’immédiat, mais c'est peut-être enfin une seconde chance pour cette technologie vantée depuis des lustres ? Côté professionel, la soupe se défend bien mieux, NVIDIA ayant des partenaires allant d'Autodesk à Epic Games en passant par Dassault et Pixar : ces alliances permettront ainsi un support de cette nouvelle architecture sur leurs logiciels d'ici mi-2019 au plus tard. (Source, Anandtech, Tom's, NVIDIA blog)

Oui, carrément... Le Ray Tracing : finalement, le nouveau terrain de bataille marketing des GPU

ces prochaines années ?

| Un poil avant ?Quakecon 2018 : entre Doom, Rage 2 et ID Tech 7 | Un peu plus tard ...Live Twitch • Dead Cells et son mode spécial Twitch |  |