Qualcomm officialise les accélérateurs AI200 et AI250 pour centres de données |

————— 27 Octobre 2025 à 19h16 —— 19835 vues

Qualcomm officialise les accélérateurs AI200 et AI250 pour centres de données |

————— 27 Octobre 2025 à 19h16 —— 19835 vues

Présente sur plusieurs marchés, dont celui des SoC pour smartphones et celui des processeurs pour PC Windows, Qualcomm souhaite désormais s’attaquer aux accélérateurs pour centres de données. Les détails techniques sont presque inexistants à ce stade, mais l’entreprise a officialisé les AI200 et AI250 : deux produits qui seront proposés sous forme de cartes d’accélération et de baies complètes à refroidissement liquide, à partir de respectivement 2026 et 2027.

L’entreprise indique que ses puces AI200 et AI250 tirent parti de son NPU Hexagon maison (Neural Processing Unit), sans plus de précisions à ce sujet. La carte AI200 embarque 768 Go de mémoire LPDDR. Quant à l’AI250, elle adopte une architecture de type near-memory compute conçue pour accroître la bande passante mémoire effective lors des inférences. Qualcomm affirme que cette conception offre une bande passante effective plus de dix fois supérieure, tout en réduisant la consommation énergétique (aucune valeur pour cette assertion).

Dans son communiqué, la société met d’ailleurs en avant la faible consommation et le coût total de possession (TCO) de ses solutions. Qualcomm prévoit une consommation de 160 kW pour une baie complète, soit un niveau comparable à celui des racks GPU concurrents. Les cartes s’appuient sur le PCIe pour les configurations scale-up et sur l’Ethernet pour les déploiements scale-out.

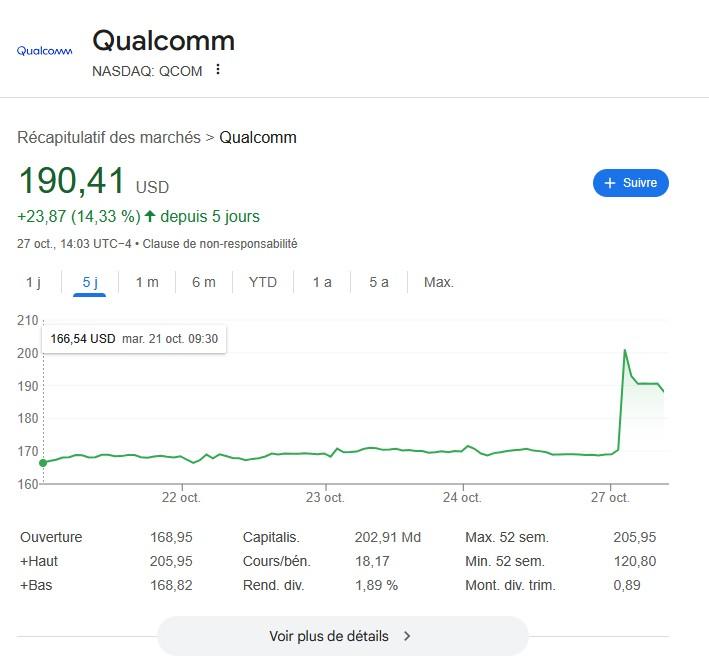

Ce n’est pas la première fois que Qualcomm tente sa chance dans les centres de données. Entre 2014 et 2017, la firme avait misé sur le SoC Arm Centriq 2400. Depuis 2020, elle s’appuie sur ses cartes Cloud AI 100 Ultra et AI 80 (page officielle ici), destinées à des serveurs standards. Ces modèles sont conçus comme des solutions autonomes, capables de faire tourner des applications d’IA dans différents environnements (centres de données, périphérie du cloud, appareils en edge ou infrastructures 5G pour reprendre le communiqué de 2020). Avec les AI200 et AI250, Qualcomm veut changer d’échelle et passer à des plates-formes IA intégrées, pensées comme des systèmes complets. Un pari que les marchés ont salué : le titre a bondi de 14 % à la suite de l’annonce.

Durga Malladi, vice-président directeur et directeur général de la division Technology Planning, Edge Solutions & Data Center chez Qualcomm, résume (traduction) :

Avec les Qualcomm AI200 et AI250, nous redéfinissons ce qu’il est possible de faire en matière d’inférence IA à l’échelle du rack. Ces nouvelles solutions d’infrastructure IA permettent à nos clients de déployer de l’IA générative avec un coût total de possession inédit, tout en conservant la flexibilité et la sécurité qu’exigent les centres de données modernes. Notre pile logicielle complète et notre écosystème ouvert simplifient plus que jamais l’intégration, la gestion et la mise à l’échelle de modèles d’IA déjà entraînés sur nos solutions d’inférence optimisées. Grâce à une compatibilité native avec les principaux frameworks IA et à un déploiement en un clic, les AI200 et AI250 de Qualcomm sont conçues pour une adoption sans friction et une innovation rapide.

| Un poil avant ?AMD recycle et renomme : bienvenue aux Ryzen 10 et 100 | Un peu plus tard ...ASUS commercialise son moniteur ROG en 720p |  |