CPU ou GPU : lequel est préférable pour bosser ? |

————— 15 Février 2021 à 11h21 —— 22967 vues

CPU ou GPU : lequel est préférable pour bosser ? |

————— 15 Février 2021 à 11h21 —— 22967 vues

Ces dernières années, depuis 2017 et l'arrivée de Ryzen, nous avons vu le segment mainstream envahir les places de feu le segment HEDT représenté par Threadripper et Cascade Lake-X. Petit à petit, les processeurs se sont musclés, avec 16 coeurs offerts par le 3950X, puis le 5950X. Les 3900X et 5900X avec leurs 12 coeurs et 24 threads ne sont pas des manchots non plus, et ils correspondent à une demande précise, avoir un max de perf en gaming et en applicatif lourd. C'est dans ce dernier domaine que la parallélisation joue le plus, mais on a également vu dans nos tests des derniers Threadripper 3000 que l'offre logicielle était en retard sur la prise en charge parfaite de toute cette puissance.

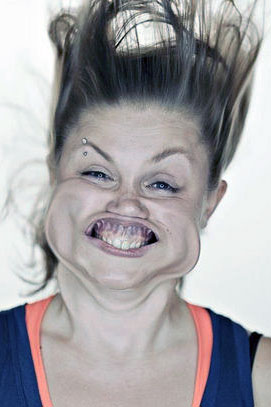

lequel décoiffe le plus entre CPU et GPU ?

lequel décoiffe le plus entre CPU et GPU ?

Mais c'est également oublier que les GPU ont commencé à se perfectionner pour des usages autres que le gaming, par exemple Nvidia a continué de développer CUDA, mais aussi son écosystème logiciel au niveau pro. Les GTX/RTX Titan représentaient le compromis entre grand public et professionnel, et c'est depuis peu que le géant vert développe une branche de pilotes estampillée Studio pour grand public afin d'exploiter au mieux certains logiciels de retouche photo/création de vidéo/encodage sur les Geforce.

Nous avons voulu faire un petit point sur ce qui était le mieux pour quelques usages précis, mais pas rares, avec une poignée de logiciels. Passons avant à la configuration utilisée :

Nous avons donc un CPU qui est tout sauf anémique, et une carte graphique réputée parmi les plus violentes pour bosser. Nous avons utilisé divers softs, comme Blender qui calcule le temps de rendu de scènes 3D, Adobe Premiere Pro et Media Encoder, Vegas Pro et DaVinci Resolve. Ces logiciels ont la capacité de fonctionner en tirant sur le CPU, ou le GPU, au choix dans les options. Le but étant de voir lequel est le plus rapide à réglage identique entre les deux. Depuis Turing, Nvidia a largement amélioré la qualité de rendu de son encodeur NVEnc, confirmé sur Ampere. Si la qualité de rendu était très largement déficiente sur GPU il y a 10 ans, ce n'est pas le cas aujourd'hui. Il a aussi développé OptiX, un moteur/framework qui optimise le rendu du Ray Tracing par le GPU, nous le retrouvons dans Blender par exemple. Est-ce que l'avenir est réservé aux GPU ou est-ce que les processeurs continuent de lutter ?

Quel que soit le test Blender/Adobe compatible Nvidia Studio, les temps de rendu ou d'encodage sont toujours à l'avantage du GPU, et la qualité visuelle du produit final est quasiment identique, avec la même qualité d'image. Media Encoder même permet un gain de plus du double entre CPU et GPU. Vegas Pro, quant à lui, met moins de temps à compiler un projet vidéo multiple fait de plusieurs rushes et d'effets sur le GPU que le CPU. Les ratios sont assez importants, et du même ordre sur DaVinci Resolve qui a une version gratuite déjà bien complète pour quiconque veut faire du montage vidéo.

Au final, on pourrait rétorquer que la RTX 3090 est une carte d'exception pour ce genre de pratique, que les gains seraient moindres avec une RTX 3060 voire une 2060, la question est de savoir jusqu'à quel moment ça devient plus intéressant de bosser sur CPU que GPU. Et encore cela dépend clairement de votre processeur, c'est donc du cas par cas. Mais nous sommes tentés de vous inciter à tester vous-mêmes pour voir ce qui est préférable sur votre configuration, mais vu l'avance de notre 3090 sur un 3900XT pas manchot, nous sommes prêts à parier que vous devriez gagner du temps à bosser sur GPU que CPU, pour peu que ceux que vous utilisez sachent tirer partie de l'accélération GPU. Il y a de plus plein de domaines pas mesurés dans ce mini article où le GPU fait des merveilles, comme les Deep PRIME de DxO Photolab qui utilisent les GPU depuis la GTX 1060 pour débruiter vos images en RAW, c'est assez bluffant. Tentez l'expérience !

| Un poil avant ?Les flammes aux fesses, NZXT rappelle officiellement le H1... aux USA et Canada | Un peu plus tard ...Un test pour le 11700K, et alors ? |  |