Test • nVIDIA GeFORCE GTX 680 |

————— 22 Mars 2012

Test • nVIDIA GeFORCE GTX 680 |

————— 22 Mars 2012

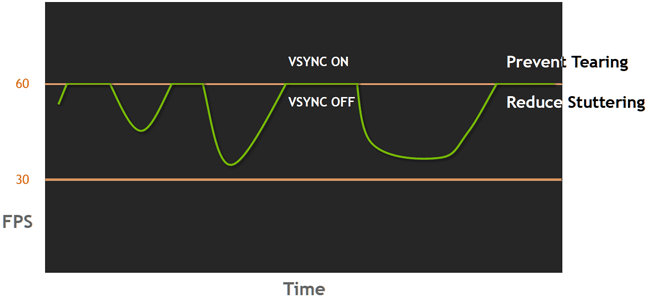

La première d'entre elle, directement accessible via les pilotes, fera plaisir à nombre d'adeptes du jeu vidéo sur PC : Adaptative VSync. En fait la plupart des joueurs en ont déjà fait l'expérience, l'activation de la synchronisation verticale est généralement source de stuttering puisque si le framerate chute sous la valeur de rafraichissement de l'écran, la synchronisation se fait alors à la moitié de cette dernière (60 i/s => 30 i/s par ex.). A l'inverse, sa désactivation entraîne souvent des déchirements de l'image pas vraiment esthétiques lorsque le nombre d'images par seconde s'envole... Le caméléon propose ici sa solution de synchronisation verticale adaptative qui se désactive automatiquement si le framerate chute pour éviter "l'effet palier" entraînant le stuttering. A noter que l'on peut choisir une synchronisation adaptative à la fréquence native de l'écran ou à la moitié pour les jeux les plus lourds et ainsi obtenir une meilleure fluidité selon les conditions :

Principe de fonctionnement d'Adaptative VSync

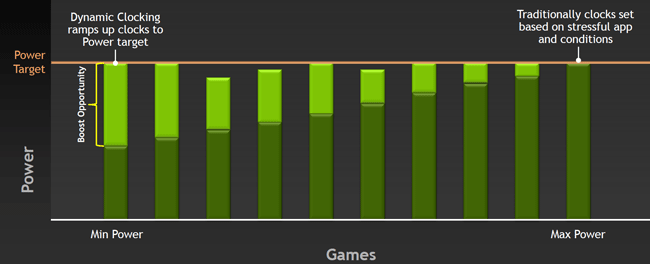

Côté fréquence du GPU, nVIDIA a fixé cette dernière à 1006 MHz sur le GK104 de la GTX 680. Toutefois, il s'agit ici de la valeur minimale garantie (Base Clock) puisque la technologie GPU Boost fait son apparition sur cette puce. En fait il s'agit d'un système approchant du Turbo Boost des CPU : la carte dispose d'un TDP défini par nVIDIA après analyse de nombreuses applications 3D et la fréquence du GPU peut varier dynamiquement dans les limites de ce TDP. Ce dernier est surveillé en temps réel par des circuits dédiés toute les 100ms et selon le type de charge, une marge peut donc exister permettant l'overclocking automatique du GPU :

Principe de fonctionnement du GPU Boost

Par défaut le gain moyen est de 5% (1058 MHz), ce par pas de 13Mhz, soit 4 pas en guise d'overclocking moyen gratis. Il est néanmoins possible d'obtenir des fréquences plus élevées selon nVIDIA. Il est intéressant de noter qu'AMD fonctionne de manière inversée avec PowerTune, puisque le fondeur communique sur la fréquence maximale atteignable par son GPU, cette dernière pouvant être amenée à chuter si les sollicitations excédent le TDP défini pour la carte, toutes fonctionnant du coup à l'identique quelque soit la qualité de leur GPU (+ ou - de courants de fuite). De son coté, le caméléon ne souhaite pas donner plus de précisions sur les variations de performances d'un GPU à un autre selon leur qualité intrinsèque. Une langue de bois assurément, qui laisse un point d'interrogation sur la variation de fréquence observable dans le cadre de GPU Boost entre les GTX 680...

Un petit mot de quelques autres fonctionnalités également apportées par ce GPU (ou les drivers série 300 l'accompagnant), notons pour commencer et pour la forme vu son utilité actuelle, le support de DX11.1. Ensuite, la prise en charge (enfin !) de plus de 2 écrans sur une même carte. Plus précisément, 4 écrans simultanés (3+1) sont désormais supportés avec gestion native du surround, gestion du bureau et autres bezel corrections (corrections au niveau des "coupures" d'un écran à l'autre), de quoi concurrencer efficacement Eyefinity Display d'AMD.

La prise en charge de 4 écrans simultanément avec une GTX 680 (saurez vous retrouver une publicité cachée sur cette photo ?)

Continuons sur le plan des features avec l'intégration au sein de la puce d'un encodeur hardware basé sur le H.264 et dénommé NVENC. Ce dernier s'avère ~4 fois plus rapide que le précédent encodeur utilisant CUDA (tout en consommant moins d'énergie), qui reste néanmoins toujours accessible sur le GK104 et peut même être utilisé simultanément à NVENC sans impact de l'un sur l'autre (tout du moins dans la partie concernant uniquement le GPU). NVENC supporte également les flux MVC des Blu-ray 3D et dispose pour être utilisé d'une API propriétaire dont le SDK a été fourni aux éditeurs de logiciels spécialisés (Cyberlink, Arcsoft).

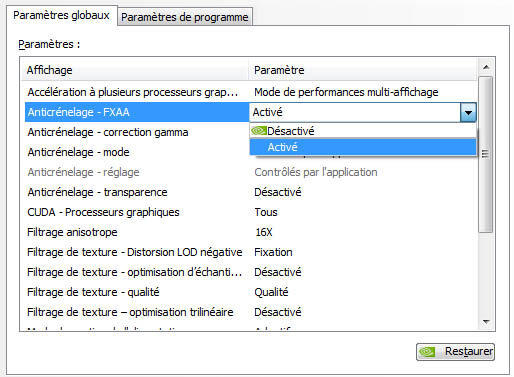

Finissons par les différents modes d'anti-aliasing proposés, le FXAA inventé par le caméléon pour permettre l'emploi d'AA dans certains moteurs à rendu différé non compatibles avec le MSAA fait son apparition au sein des pilotes : de quoi utiliser ce filtrage dans de nombreux jeux qui en sont dépourvus ! Notons qu'il existe plusieurs versions de ce filtrage et c'est un mix de ces dernières qui est intégré dans les drivers proposant un compromis entre qualité et performances :

Activation du FXAA via les drivers, un vrai plus !

Avant de passer à la description de la GTX 680, un dernier mot sur le TXAA, un nouveau mode d'anti-aliasing développé par le caméléon et pouvant mixer MSAA, AA Resolve et composante temporelle. Egalement éligible aux séries 400 et 500, le résultat serait un niveau qualitatif supérieur au MSAA 8x pour le coût du 2x et un second mode impactant dans les mêmes proportions que le MSAA 4x mais avec une qualité largement supérieure au MSAA 8x selon nVIDIA :

Le TXAA vrai progrès ou un coup d'épée dans l'eau ?

Une démo léchée a été projetée lors de la présentation de la carte, difficile pour l'heure du juger de son efficacité en l'absence de réels titres mesurables, reste donc à attendre sa mise en pratique en jeu ! NVIDIA a publié une vidéo présentant tout ce petit monde peu avant la parution de cet article, les images étant souvent plus parlantes que les mots, voyez par vous même :

Passons à présent à ce qui vous intéresse tous : la carte, page suivante.

|

|

| Un poil avant ?Les GeForce 301.10 WHQL pour GTX 680 sont disponibles | Un peu plus tard ...GlobalFoundries fête son 250 000e wafer 32nm |  |