CGVQM, l'échelle d'Intel qui détermine scientifiquement si votre jeu est moche |

————— 18 Juillet 2025 à 14h54 —— 28043 vues

CGVQM, l'échelle d'Intel qui détermine scientifiquement si votre jeu est moche |

————— 18 Juillet 2025 à 14h54 —— 28043 vues

Le mois dernier, Intel a dévoilé CGVQM (Computer Graphics Visual Quality Metric), un outil open source conçu pour évaluer la qualité visuelle des images générées en temps réel dans les jeux vidéo.

Dans un billet de blog, la firme rappelle que la plupart des métriques utilisées aujourd’hui — comme le PSNR (Peak Signal-to-Noise Ratio) ou le SSIM (Structural Similarity Index) — ont été pensées pour détecter les artefacts de compression : blocs, flous ou bandes de couleurs, typiques des vidéos trop compressées sur des plateformes comme YouTube ou Netflix.

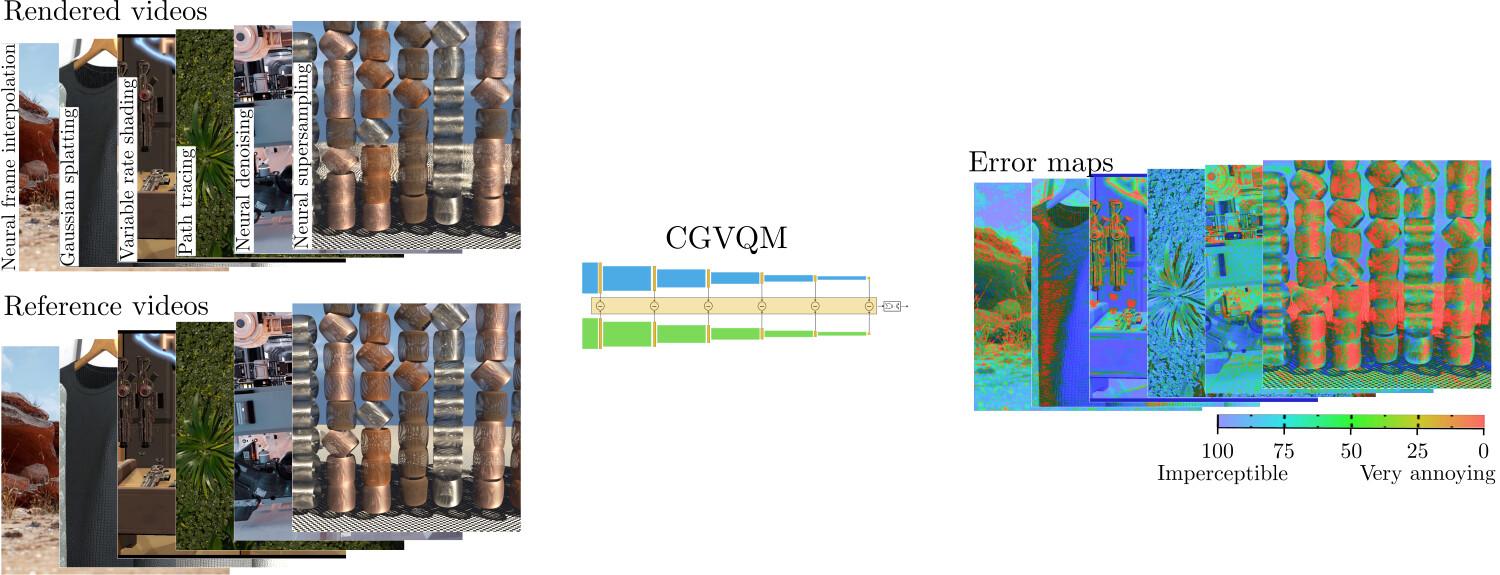

Mais ces outils montrent vite leurs limites face aux techniques de rendu modernes utilisées dans les jeux. Le super-échantillonnage neuronal (DLSS, XeSS), le path tracing, la synthèse de vues (via le Gaussian splatting 3D), l’interpolation d’images, le débruitage neuronal et l’ombrage à taux variable génèrent des artefacts bien différents : ghosting, scintillement temporel, bruit visuel, voire textures « hallucinées » issues de réseaux neuronaux. Ces défauts sont souvent spatio-temporels, c’est-à-dire qu’ils évoluent à la fois dans l’espace (zones de l’image) et dans le temps (d’une frame à l’autre).

Pour les déceler, les chercheurs d’Intel ont voulu concevoir une métrique plus adaptée, répondant à quatre critères clés : détecter ces artefacts en se rapprochant de la perception humaine ; fournir des scores lisibles (ex. : « imperceptible » vs « agaçant ») sur une échelle interprétable ; expliciter les résultats via des scores de qualité et proposer des cartes d’erreurs localisant les défauts ; fonctionner sur des contenus très variés, « allant d’environnements stylisés de fantasy à des mondes ouverts photoréalistes, et ce, quel que soit le type de technique de rendu employée ».

Le fruit de ce travail, c’est CGVQM, basé sur le jeu de données CG‑VQD : 80 extraits de scènes 3D open source rendus avec les six techniques précitées. Pour entraîner l’outil, l’équipe d’Intel a ajusté un réseau ResNet-18 3D préentraîné, calibré pour que ses prédictions correspondent au mieux aux jugements d’un panel humain. Selon elle, CGVQM‑5 surclasse toutes les métriques classiques à référence complète, avec une précision proche de l’évaluation humaine.

En pratique, CGVQM découpe les vidéos en segments, extrait leurs caractéristiques visuelles, puis jauge des paramètres pour générer un score. CGVQM‑5 exploite l’ensemble des cinq blocs du réseau pour une précision maximale. Une version plus légère, CGVQM‑2, se limite aux deux premiers blocs.

Les deux versions peuvent générer des cartes d’erreurs visuelles, permettant de repérer rapidement les artefacts sans recourir à des tests utilisateurs. L’outil peut s’intégrer directement dans un moteur comme Unreal Engine ou un pipeline Vulkan, pour un suivi continu de la qualité graphique au fil du développement.

Plus d’infos sur GitHub et dans l’article de blog d’Intel (rendons à César ce qui est à César : découverte faite via de récents articles de TPU et TH).