L'Intel Iris Pro 5200 GT3e testé : AMD rattrapé en perfs GPU ? |

————— 05 Juin 2013 à 11h39 —— 27683 vues

L'Intel Iris Pro 5200 GT3e testé : AMD rattrapé en perfs GPU ? |

————— 05 Juin 2013 à 11h39 —— 27683 vues

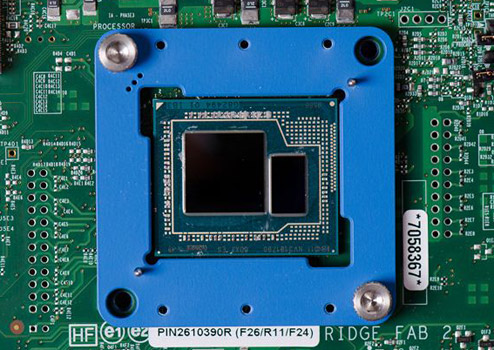

Avec l'arrivée d'Haswell, tout le monde a bien rapidement compris que la principale source de nouveauté n'était finalement pas à chercher du côté de la partie CPU du processeur, mais plutôt de son GPU particulièrement en ce qui concerne la fameuse version "GT3e" alias Iris Pro 5200 avec sa mémoire intégrée au processeur.

Intel a souhaité voir disparaitre la mention "HD" pour appuyer sur le gouffre de performances qui le sépare des générations précédentes de GPU intégrés et opté donc pour une nouvelle dénomination, est-ce que ce choix se vérifie en pratique ? Nos confrères d'Anandtech ont pu mettre la main sur un Haswell mobile Core i7-4950HQ avec donc son Iris Pro 5200 de 40 EUs possédant une fréquence maximale de 1300MHz pour 832 GFLOPS. L'occasion de l'opposer aux HD 4000 et 4600 d'Intel mais aussi aux GT 650M et GT 640 de Nvidia. Sous quelques benchmarks (pas tous), les HD 7660D et HD 7660G intégrés aux APU d'AMD sont également présents pour avoir une idée face au Trinity d'AMD.

| Un poil avant ?Crucial Ballistix Sport XT: qu'est-ce qui est bleu et vert et fait 5cm de haut ? | Un peu plus tard ...Les SanDisk Extreme II 120, 240 et 480Go en test |  |