Apple lance son M1 Ultra, au bon goût de chiplets |

————— 09 Mars 2022 à 16h07 —— 25064 vues

Apple lance son M1 Ultra, au bon goût de chiplets |

————— 09 Mars 2022 à 16h07 —— 25064 vues

Hier se tenait la dernière keynote d’Apple, une séance d’autocongratulation live ponctuée d’annonces de nouveaux produits à la vitesse quasi luminique. Entre le nouvel iPad Air, le Studio Display, le Mac Studio, il y avait largement de quoi se perdre... Petit démêlage orienté SoC avec le Comptoir. Hasard du calendrier, cet événement se place peu après la découverte d’un sympathique mod du Mac Mini - qui n’a par ailleurs pas connu de mise à jour en dépit de son alimentation et refroidissement surdimensionné : coïncidence ? Nous ne le croyons point !

Si, côté iPad, la sauce interne est bien connue puisque le SoC n’est autre que le M1, première puce Arm intégrée dans un MacBook en fin d’année 2020, l’iPhone n’est guère plus croustillant puisqu’il n’est question que d’un nouveau coloris et d’un SE intégrant l’Apple A15 bionic déjà connu. Non, la grande nouveauté de la pomme se situe dans le M1 Ultra, un nouveau SoC de la firme... avec un petit goût de déjà-vu. En effet, tel AMD dévoilant que ses dies Zen 3 avaient été en fait optimisés pour accueillir un 3D V-Cache, Apple avait caché une petite partie de sa puce : un interconnect maison offrant quelques 2,5 Tio/s de bande passante.

Un M1 Ultra ? C’est Ultra bien fichu !

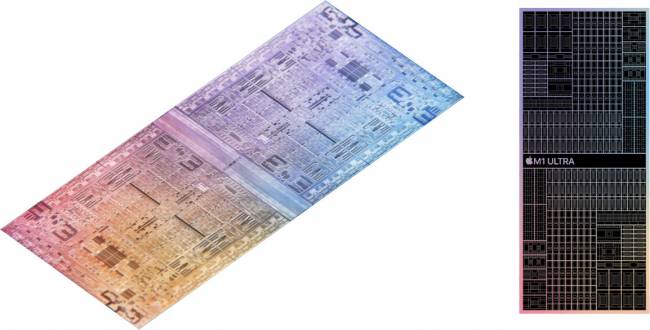

Pourquoi faire ? Hé bien, relier deux M1 Max ensemble via un interposer afin de produire à plus bas coût une puce à la fois économe et performante, le M1 Ultra : une idée bien en vogue ces temps-ci avec les chiplets des rouges. Et, tout comme les chiplets des rouges, nous émettons quelques réserves sur le scaling des applications sur cette topologie : en gluant ensemble deux SoC, vous obtenez certes deux fois plus de cœurs CPU, de cœurs GPU et de contrôleurs mémoire, mais leur partage n’est pas si évident. Des effets nommés NUMA (côté RAM) et NUCA (pour le cache) peuvent ainsi apparaître comme ce fut le cas sur Zen 1 et son cache distribué entre deux CCX sur les dies Zepplins (plus de précisions à ce sujet par ici !). À l’époque, l’interconnet utilisé, l’Infinity Fabric, était un peu faiblard pour la tâche, d’où des performances en demi-teinte : à voir comment Apple a cuisiné sa sauce sur ce coup et mêlé efficacement architecture et politique de gestion de cette dernière au niveau système. Par contre, au niveau com', c’est parfait : en multipliant le nombre de canaux mémoires supportés, la bande passante maximale est également boostée : de quoi afficher 800 Gbits/s, soit un peu plus que... la RTX 3080. De plus, la distribution de la charge de travail au niveau du GPU doit davantage relever du SLI que des traditionnelles architectures monolithiques ; mais, étant donné la clientèle professionnelle ciblée par le bousin, cela ne devrait pas être trop handicapant.

Nommé UltraFusion, cet assemblage de deux dies permet d’offrir le support de 128 Gio de RAM « unifiée » (soudée), un CPU à 20 cœurs comprenant 16 gros (48 Mio de L2 en tout) pour 4 petits (8 Mio de L2 de ce côté), complémenté par un GPU à 64 cœurs maximum (8192 unités d’exécution, pour 21 TFLOPS de puissance brute) et un accélérateur de réseau de neurones à 32 cœurs (22 TOPS annoncés). Pour le reste, les fréquences ne sont pas plus officielles que le reste de la microarchitecture : pour les curieux, c’est niet ! En outre, côté performance, difficile de se prononcer tant la maison-mère sélectionne attentivement ses métriques au moyen de truchements en annonçant les gains maximums et non moyens... Nous bottons donc en touche sur ce sujet, si ce n’est qu’elles devraient être encore supérieures au M1 Pro et Max : encore heureux ! Par contre, le TDP n’est pas dévoilé, et risque de tourner autour de la centaine de Watt en lisant entre les lignes des maigres chiffres disponibles et au vu du refroidissement actif des modèles proposés.

Car, puisque cet Apple M1 Ultra n’est pas sur socket, il faut bien l’acheter quelque part : voilà la responsabilité du Mac Studio, une nouvelle machine de la firme ressemblant à un Mac Mini un peu plus haut, pour des performances largement plus grandes, puisqu’intégrant au choix un M1 Max ou un M1 Ultra. Notez la compatibilité Wifi 6, Bluetooth 5 ainsi que l’intégration de 4 ports Thunderbolt 4, 2 USB 3,1 gen 1, le classique Ethernet 10 Gb ainsi qu’un jack optimisé pour les appareils à haute impédance. Rajoutez un port HDMI ainsi que 2 USB 3,1 Type-C sur la façade — Thunderbolt 4 si vous optez pour une version M1 Ultra - et voilà pour ce Mac Studio. Si jamais vous souhaitez vous en procurer un, les tarifs commencent à 2299 € pour une livraison le 18 mars, prix pour lequel vous aurez accès à un M1 Max (10 cœurs CPU + 24 GPU), 32 Gio de VRAM et 512 Gio de SSD. Pour un M1 Ultra, ce ticket d’entrée grimpe à 4 369 € (pour 20 cœurs CPU et 48 GPU), la RAM grimpant elle aussi pour atteindre 64 Gio. Avec toutes les options maxées, vous en aurez pour la bagatelle 9 199 € (et la RAM soudée...) : un bon Mac, ça se mérite !

| Un poil avant ?Tout juste lancé, déjà testé, Relic of Life sur les GPU compatibles RT hardware | Un peu plus tard ...La baisse du prix des CG se poursuit en Allemagne... |  |