Du hardware chez Tesla pour les voitures autonomes |

————— 25 Avril 2019 à 12h17 —— 10105 vues

Du hardware chez Tesla pour les voitures autonomes |

————— 25 Avril 2019 à 12h17 —— 10105 vues

Alors que les concepteurs de puces se battent au concours de qui à la plus grosse (en transistor) et la plus fine (en gravure), ce n'est pas toujours ce que l'industrie attend. En effet, côté automobile, un secteur désormais aussi mature que la chevelure de Pascal, le concept utopique il y a quelques années seulement de voiture autonome commence à prendre forme.

Dans la course, Tesla, dirigé par le célèbre Elon Musk, qui en dépit de forte baisse sur le dernier trimestre (il serait question d'une diminution de 31% des ventes par rapport au trimestre précédent !) a récemment dévoilé ses puces à destination de ses véhicules à conduite automatique. Suivant sa politique de construction de bout en bout, c'est par une conception 100% maison que le bouzin a vu le jour. Il s'agirait tout bonnement de la plus grande puissance de calcul jamais intégrée dans un véhicule avec 144 TOPS dans 72 W, pas mal ! Si la comparaison avec la nouvelle GTX 1650 (75W pour un maximum de 6 TFLOPS) semble directe, cela est inapproprié : la GTX propose sa puissance en FP16, alors que l'unité des opérations de ces 144 TOPS (sans F !) n'est pas précisée.

En revanche, nous connaissons les processus de fabrication de la bête : du 14 nm Samsung made in USA (usine d'Austin au Texas) pour quelques 6 milliards de transistors dans 260 mm², similairement à une RX 590 (232 mm² pour 5,7 milliards de transistors). À l'intérieur, deux accélérateurs neuronaux pas si différents de la plateforme NVIDIA Xavier, capables de fournir 9 216 MAC/s (multiplication-accumulation par seconde) chacun, et deux puces seront intégrées pour chaque voiture soit 4 accélérateurs distincts en tout ! Toujours pour chaque trukaneurones, 4 Mo de SRAM seront intégrés et le tout moulinera à 2 GHz. Les Teslas n'auront donc pas que des chevaux sous le capot.

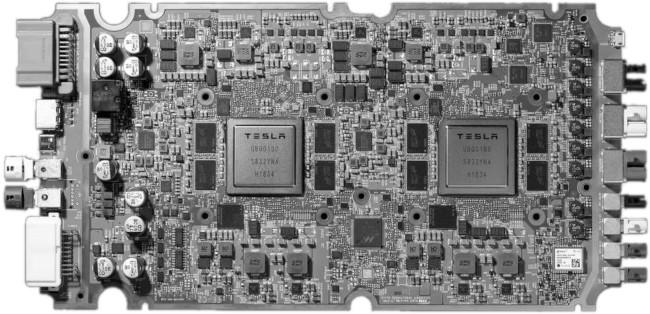

Le PCB nu de la belle

Pour ce qui est de la pile logicielle, un algorithme top-secret est développé dans la base souterraine d'Elon et devrait être incorporé dans leurs machines à l'horizon 2020. Si la firme annonce une armée de "robots-taxis", nous nous doutons que la réalité sera davantage nuancée - et plus encore dans nos contrées européennes, d'autant plus que cette puce ne servira encore qu'à l'assistance à la conduite, et non celle 100% automatisée qui est le saint Graal actuel. Néanmoins, en piochant dans la partie fortunée de la population, voilà une invention qui devrait trouver acquéreurs ! (Source : EETimes)

| Un poil avant ?Le R7 2700X 50th Anniversary se dévoile un peu plus, comment dire... | Un peu plus tard ...Fractal complète son catalogue avec un S2 et du moulin |  |