Cascade Lake est officiellement sorti, encore du 14 nm pour serveurs ! |

————— 03 Avril 2019 à 13h01 —— 19460 vues

Cascade Lake est officiellement sorti, encore du 14 nm pour serveurs ! |

————— 03 Avril 2019 à 13h01 —— 19460 vues

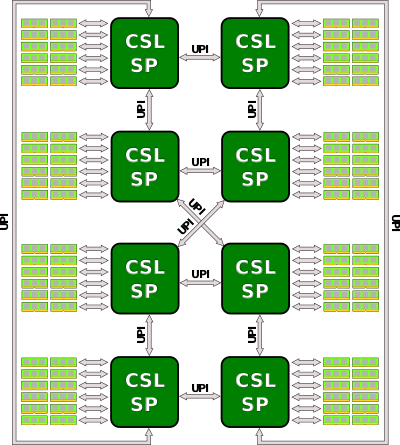

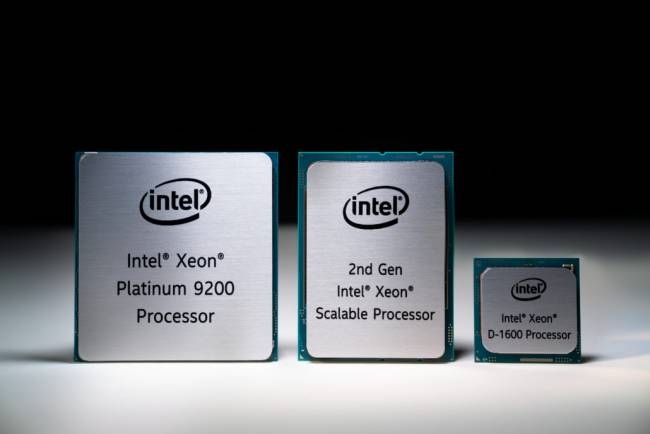

Annoncée à l'Architecture Day, ça y est, la nouvelle génération de CPU pour serveur chez Intel est là, et elle apporte du lourd ! Bien que toujours en 14 nm (itération 14nm++ tout de même), Intel a trouvé le moyen de caser la bagatelle de 56 cœurs et 112 threads sur une seule socket. Mais quelle est cette sorcellerie ? Les quatre processeurs de la série 92 Haut-de-Seine représente la famille (9282, 9242, 9222 et 9221 ; à respectivement 56, 48, 32 et 32 cœurs hyperthreadés) comprennent en fait deux dies de 28 cœurs maximum d'où un TDP maximum prêt à vous envoyer sur la lune : 400 W pour le plus gros, ce Xeon Platinium 9282 aux fréquences pourtant pas si hardies que ça de 3,8 GHz en boost, et 2,6 de base. La communication ne se fait en interne malheureusement pas par un interconnect maison type EMIB, mais via une réutilisation de l'UPI (UltraPath Interconnect) habituellement dédié aux liens des configurations multi-sockets de la firme.

![Si vous cliquez, vous cliquez. C'est sûr qu'avant, il n'y en avait pas assez déjà... [cliquer pour agrandir]](/images/stories/_cpu/14nm_intel/intel-cascade-lake-liste_t.jpg)

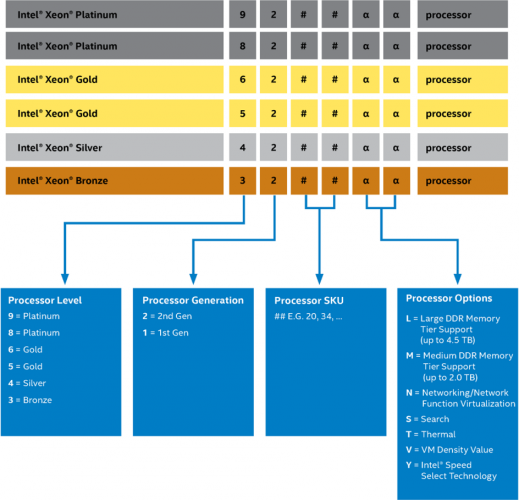

Niveau nomenclature, on a regardé... et on a rien compris. Puis on a regardé encore, plus près... du 9000 (qui n'existait pas dans Skylake-SP), du 8000, du 6000, du 5000, et même du 4000, un unique 3204 à six cœurs aussi perdu que nous, du N, du T, du S, du L : obscur comme un Pac de lendemain de soirée à 7h du matin. Le temps de prendre un pastis, et nous nous rendons compte qu'Intel nous avait en fait donné son secret :

Contrairement à toutes les nomenclatures, c'est le second chiffre qui va donner la génération. Vous nous direz, c'était déjà le cas pour la première itération.... mais on était déjà ronchons à ce sujet ! Quant au reste... nous cherchons encore, par exemple en quoi le 5220S à 18 cœurs @ 2,7-3,9 GHz (125W de TDP) est plus "optimisé pour les recherches" que le 5220T, exactement le même avec 105W de TDP et une fréquence de base baissée à 2,1 GHz. Certes, ce dernier possède une certification NEBS (Network Equipment-Building Practice) lui assurant une certaine qualité, mais est-ce pour autant qu'il devient plus résistant à la chaleur ? La segmentation de la gamme ne date pas d'hier, mais elle fait tout de même fort sur ces 45 références. Au moins est-on sûr que chacun y trouvera son bonheur.

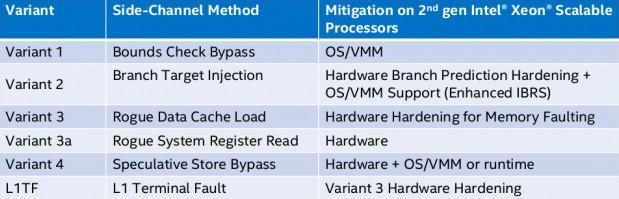

Trêve de rabâchage gratuit, le nom ne fait pas le moine, et c'est encore plus vrai chez les professionnels. Commençons plutôt cette revue des nouveautés internes avec les corrections des failles découvertes en 2018 de la série Spectre/Meltdown :

Normalement tout est bon, tout est patché, il n'y a pas de pertes de performances supplémentaires à attendre du fait de patchs kernels ou autres joyeusetés du genre, ouf ! Tout comme Skylake-SP, les CPU Cascade Lake supporteront des configurations multi-CPU jusqu'à 8 sockets, encore faut-il que le CPU soit compatible. N'espérez cependant pas caser 8 Xeon Platinium à 56 cœurs, la série 92XX est limitée à du dual-socket épicétout, utilisation de l'UPI en interconnect interne oblige. De toute manière, bon pour des raisons de dégagement thermique, il valait sûrement éviter : 3200W rien que pour les CPU ça devait faire un peu beaucoup. Pour relier 8 CPU ensemble, il faudra se rabattre sur des Xeon Platinium 8280 à 28 cœurs, ce qui donnera tout de même 224 cœurs physiques (et 442 logiques) pour un TDP total de 2000W, nom de dieu !

Au niveau des fonctionnalités, Cascade-Lake est une optimisation de Skylake-SP et n'ajoute donc aucun changement majeur, à deux exceptions près. D'une part, l'AVX-512 se pare d'une nouvelle instruction spécialement dédiée au Deep Learning : vpdpbusd (on aurait voulu inventer un nom imprononçable qu'on n’aurait pas réussi mieux...), mieux connue sous le nom de VNNI (Vector Neural Network Instruction). Cette dernière réalise tout simplement une multiplication avec accumulation vectorielle, très très très proche de ce qu'effectue un Tensor Core chez NVIDIA (à la différence que le Tensor Core opère sur 4 matrices 4x4 16-bits maximum, alors que l'AVX-512 est limité aux calculs simultanés sur 64 entiers 8-bit). Si de nouvelles unités de calcul ne sont pas présentes, cette amélioration permet de tripler le débit maximal dans le cas de multiplication de matrices en se passant du décodage des deux instructions supplémentaires nécessaires à obtenir un résultat identique sur Skylake-SP.

En parlant de Skylake-SP, tous ces CPU Cascade Lake sont compatibles avec le socket précédent (plateforme Purley - Socket Lewisburgh), à l'exception des 92XX. Pourquoi ? Tout simplement parce que le mode d'intégration de ces puces est... le BGA, la soudure pure est simple par billes de métal, 5903 très exactement. Certes, il est assez rare de mettre à jour un serveur (il est usuellement remplacé dans son intégralité), la maintenance d'une unité défectueuse peut passer par un changement du CPU, rendue impossible avec ces modèles. Il est très probable que, pour une fois, cette limitation ne soit pas une segmentation marketing, mais une nécessité due au fait que l'architecture Skylake-SP n'a pas été conçue autour d'une possibilité de socket à plusieurs dies (contrairement à EPYC chez AMD). Il semble clair que le but de ces puces n'est que d'être une vitrine face à son concurrent en proposant 56 cœurs sur une socket là ou AMD n'en offre que 32 maximum. Si techniquement, la prouesse mérite respect, ce n'est pas pour autant qu'elle en est utile : entre la soudure et les performances nécessairement réduites par contraintes thermiques, mieux vaut opter pour une solution à deux dies. Hé oui, multiplier les bouts de silicium, ça marche chez AMD parce que le procédé leur permet de diminuer leurs coûts de production. En effet, les gros dies sont bien plus difficiles à graver que les petits (la présence d'un défaut sur ledit die est proportionnel à sa surface, dans le cas de deux petits dies, on en garde un, dans un gros, tout est à jeter), autant dire que 4 Zepplins à 8 cœurs chez AMD, c'est malin ; alors que 2x28 chez Intel, c'est la subtilité d'un char d'assaut soviétique.

Si mettre deux dies ensembles double la taille de la socket et apporte les mêmes performances qu'une configuration à deux sockets, pourquoi diable s'embêter les coller ? (Réponse : Demander à Bob du marketing)

L'autre ajout architectural est le support d'Optane DC. Revues en long, en large et en travers, ces barrettes de 3DXPoint utilisées dans les SSD Pro des bleus et en tant que cache de HDD/SSD pour le grand public peuvent être installées conjointement à la RAM standard sur cette génération. Il ne faudra cependant pas surcharger votre système d'Optane : pas plus de 512 Go par barrette (!), sachant que 128 Go sera la taille minimale pour cette technologie. Notez que ces modules seront soit utilisés comme de la RAM via un allocateur spécifique se chargeant de la gestion de la RAM standard qui servira alors de cache, soit laissés librement à l'application comme un espace disque temporaire. Si cela ne concerne pas encore le grand public, on peut imaginer des utilisations pour le domaine vidéoludique pour, par exemple, des sauvegardes écrites en continu sur cette partie qui survivraient en cas de crash du jeu.

Nous mentionnons également le support de la RAM standard qui passe d'un 2666 MHz officiel à un 2933, cela semble anodin pour le grand public, car les hautes fréquences y sont un argument marketing, mais les contraintes sont souvent plus strictes pour les professionnels à cause de la correction d'erreur : cette prise en charge native devrait donc améliorer l’expansion de la DDR4-2933 dans ce secteur. De plus, la quantité maximale embarquable double pour passer à 1,5 To ; certains trouverons probablement ça pratique. À titre de comparaison, c'est un maximum de 3 To d'Optane qu'il sera possible de mettre (et uniquement sur les CPU suffixés "L", pour le total annoncé de 4,5 To de RAM).

Pour une fois, un test est disponible au lancement chez notre confrère Phoronix. N'espérez pas y voir Crysis, on se doute qu'il tourne très mal vu les difficultés de Windows à gérer efficacement autant de cœurs : inutile de râler. Par contre, face à EPYC, le combat est mouvementé. Selon les applications c'est tantôt aux rouges, tantôt aux bleus de mener la danse, le multi-CPU étant parfois aussi bien supporté que le SLi, c'est à dire pas du tout (mais uniquement sur certaines applications !). Grâce à l'AVX-512, l'avantage des performances est souvent côté Intel, et même pour ce qui est du ratio performances/prix... mais à condition de bien l'utiliser (par exemple pour du calcul scientifique, souvent basé sur de la physique linéaire utilisant à tire-larigot des matrices). Dans le cas contraire (par exemple de la compilation), il vaudra mieux préférer une solution de chez AMD. On n'oubliera pas le petit test de vérification des implémentations des correctifs Spectre & Cie, et tout semble bien aller de ce côté-là : les switchs de contexte (passage du mode utilisateur au mode noyau, opération effectuée lors d'accès aux fichiers par exemple) se payent le luxe d'être plus rapide que sur EPYC, un très bon point. Pour pinailler, on aurait aimé avoir les résultats de consommation énergétique, car cette dernière représente environ la moitié du coût total d'un supercalculateur une fois son cycle de vie écoulé, et c'est bien à cet effet que sont majoritairement destinés ces CPU. POur les prix, on ne connais pas encore ceux des multi-dies, mais les autres peuvent grimper jusqu'à 17 906 dollars le processeur pour un Xeon Platinium 8280L. Allez, une petite lame pour chauffer la maison désormais hypothéquée ?

Ni vu ni connu, la classe pour votre maison (les oreilles ne sont par contre pas garanties d'apprécier !)

| Un poil avant ?AMD a déjà sa keynote prévue au Computex | Un peu plus tard ...X499 et X570 chez GIGABYTE |  |