Le futur des Xeon Phi dévoilé : Knights Landing en 14nm |

————— 05 Juillet 2013 à 14h27 —— 24873 vues

Le futur des Xeon Phi dévoilé : Knights Landing en 14nm |

————— 05 Juillet 2013 à 14h27 —— 24873 vues

Actuellement composée des Knights Corner gravés en 22nm, la gamme Xeon Phi d'Intel devrait avoir droit l'année prochaine à un important rafraichissement lui permettant de multiplier par 3 environ la puissance de calcul en double précision du coprocesseur pour supercalculateurs d'Intel. De quoi continuer à proposer un 3e choix en plus d'AMD et Nvidia qui, eux, obligent à passer via le GPU là où Intel, pour rappel, permet de rester sur une archtecture 100% x86 en cumulant CPU Xeon et coprocesseur Xeon Phi au lieu du classique CPU + GPU.

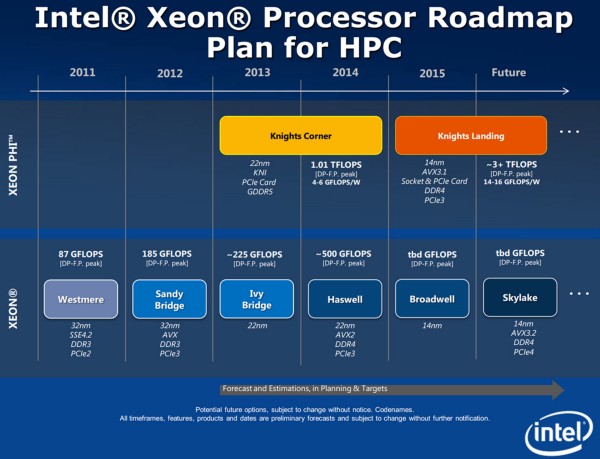

Selon une roadmap dévoilée par nos confrères de X-bit labs, Intel aurait dans ses cartons une nouvelle génération de Xeon Phi pour l'année prochaine, avec pour nom de code Knights Landing. Le 22nm laisserait la place au 14nm, avec une puissance de calcul en double précision annoncée aux alentours de 3 TFLOPS contre 1.2 TFLOPS pour rappel au plus puissant des Xeon Phi actuels (le 7120 avec 61 coeurs à 1.24GHz, 30.5Mo de cache L2 et 16Go de GDDR5 à 1375MHz). Un impressionnant gain de puissance donc, qui se traduirait par un ratio compris entre 14 et 16 GFLOPS / W contre 4 à 6 GFLOPS / W pour les Knights Corner.

A noter également que les Knights Landing devraient être toujours proposés en cartes PCIe à la norme 3.0, mais aussi cette fois en socket. Il est également question de délaisser la GDDR5 au profit de la DDR4.

|

Et ne t'inquiète pas pour moi, je me laisse rarement prendre au piège marketingo-journalistique qu'Intel sait si savamment orchestrer.