NVIDIA s'intéresse toujours autant aux améliorations d'image par réseau de neurones : vers un DLSS 3.0 ? |

• 16 Avril 2020 à 14h33 • 12950 vues

NVIDIA s'intéresse toujours autant aux améliorations d'image par réseau de neurones : vers un DLSS 3.0 ? |

• 16 Avril 2020 à 14h33 • 12950 vues

Alors que le DLSS 2.0 est sorti il y a un peu plus d’un mois, NVIDIA ne se repose pas sur ses lauriers pour autant. En effet, un papier a été soumis au journal Computer Graphics Forum concernant une amélioration d’une technique existante, le deep adaptative sampling and reconstruction (DASR).

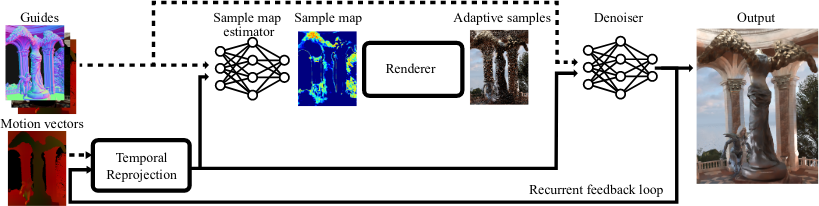

L’idée de base du DASR consiste à reconstruire une image à partir de données incomplètes savamment choisies. L’idée, proche conceptuellement du Coarse Pixel Shading de chez Intel et de l’Adaptative Shading chez NVIDIA, est de diminuer la qualité de pixels calculés (pour un rendu 100 % au lancer de bâtons, vous comprenez l’intérêt niveau performances) et d’utiliser un réseau de neurones pour reconstruire l’image, avec une subtilité : c’est également un réseau de neurones qui vient décider où passer le temps de calcul (d’où le terme adaptative sampling), au lieu de stopper le rendu pour tous les pixels après un certain temps ou un certain nombre de rayons.

Le schéma d’organisation du schmilblick de NVIDIA

Sur papier, cela est bien beau, mais un soucis de taille se pose dans la réalité : l’algorithme s’accomode très mal d’une vidéo, le double réseau n’étant pas assez souple pour proposer des images parfaitement cohérentes temporellement, donnant un effet « esquisse » certes artistique, mais pas vraiment du goût du photoréalisme recherché.

Pour pallier ce problème, des chercheurs de chez NVIDIA ont mis au point une nouvelle technique, basée sur... toujours plus de machine learning, youpi ! Grâce aux vecteurs vitesse directement disponibles dans le moteur de rendu, l’algorithme a été modifié pour ne retracer que les parties en mouvement, et pouvoir réutiliser les informations de la frame précédente au lieu de recalculer inutilement le rendu ray tracé — ce qui n’est pas sans rappeler un travail précédent de la firme. Par exemple, dans une cinématique où la caméra resterait fixe, le réseau ne calculerait plus que les détails des personnages, sans se soucier de l’arrière-plan. Le résultat est très propre, bien que certains mouvements légers comme les ombres faiblement marquées ne soient pas encore correctement reproduits, le réseau ayant en effet trop tendance à réutiliser le rendu précédent, ce qui crée un ghosting malvenu.

Les explications, en vidéo

Pour le moment encore dans les papiers, il ne fait aucun doute que ces recherches soient dirigées dans le seul but d’améliorer la vitesse de rendu des RTX vertes. Bien que nous soyons encore loin d’une application directement intégrée dans les pilotes, les résultats sont largement prometteurs... Peut-être une inspiration pour un DLSS 3.0 ?

| Un poil avant ?Pilotes Geforce pour Minecraft RTX et d'autres jeux | Un peu plus tard ...Live Twitch • Oh, un MW2 remasterisé ?! |  |