La GDDR6 produite en masse chez SK Hynix d'ici 3 mois ? |

————— 05 Avril 2018 à 10h51 —— 21374 vues

La GDDR6 produite en masse chez SK Hynix d'ici 3 mois ? |

————— 05 Avril 2018 à 10h51 —— 21374 vues

Le GTC 2018 s'est révélé être d'un ennui fort pour le commun des mortels, les joueurs en particulier, rien n'a été dit et rien n'a été dévoilé sur la prochaine génération de GeFORCE, dont même la nomenclature reste encore un mystère ! GTX 11xx ? GTX 20xx ? Obi-Wan Kenobi ? D, la réponse D ? Qui sait. Mais peu importe, ce qu'on veut c'est du neuf capable de nous faire oublier Pascal et qui saura pédaler sur du 4K à l'aise et sans les mains ! Heureusement, Thibaut était là, bière en main, pour animer le live d'un Jensen Huang à l'autosatisfaction débordante !

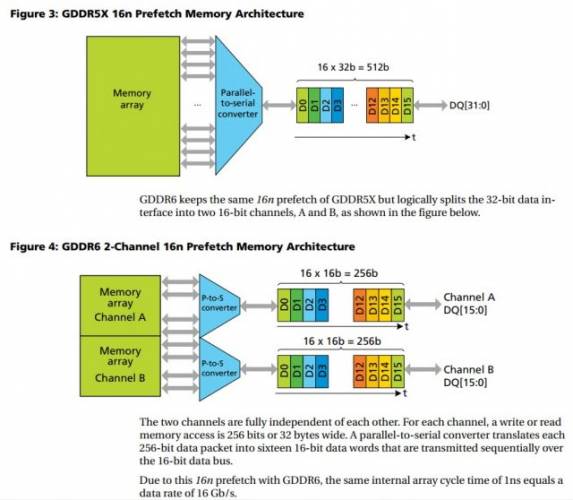

Heureusement, d'autres y ont su glaner des informations auprès des divers intervenants. Ainsi, Gamersnexus aurait appris du constructeur SK Hynix que sa GDDR6 - disponible au catalogue depuis janvier - est planifiée pour une production de masse dans 3 mois, soit sur la période juin-juillet. En sus, il aurait été précisé que celle-ci sera présente sur un bon nombre de futurs produits NVIDIA, autant sur du matériel de véhicules autonomes que sur une partie - si ce n'est pas tous - des prochains GPU du caméléon.

En supposant que SK Hynix soit l'un des partenaire-fournisseur de la première heure pour le lancement de la nouvelle gamme - mais n'oublions pas que Samsung et Micron sont aussi sur le coup de la GDDR6 depuis un moment déjà, le géant coréen en tête - ceci permettrait de situer à l'aveuglette ledit lancement au-delà du début de la production en masse de GDDR6 signée SK Hynix, et peut ainsi laisser entrevoir une hypothétique disponibilité de nouvelles GeFORCE aux alentours de juillet-août. Évidemment, ce n'est que de la spéculation, hélas, rien n'est encore concret. Pourtant, si cela devait bien être le cas, le Computex 2018 prenant place du 5 au 9 juin serait alors l'occasion idéale pour NVIDIA de faire son show ! Par ailleurs, c'est aussi en juillet qu'est prévue l'arrivée du support du RTX de NVIDIA pour Volta au sein de l'Unreal Engine 4.20. Coïncidence ? Wait & see !

Mais assez tergiversé et rêvassé, revenons un moment vers la GDDR6. Toujours au GTC 2018, SK Hynix aurait aussi avoué que la GDDR6 sera 20% plus chère à produire en masse que la GDDR5, tout du moins initialement en attendant l'amélioration des rendements et la mise à niveau des lignes de productions de GDDR5 vers la GDDR6. Logiquement, cette différence devrait être répercutée par les constructeurs sur les tarifs de leurs produits finaux, un point qui nous rappelle aussi une nouvelle fois des rumeurs selon lesquelles les prochaines GeFORCE du caméléon pourraient bien afficher un tarif MSRP sensiblement plus élevé que d'habitude. Éventuellement, cet écart de coût entre la GDDR5 et GDDR6 devrait se tasser à 15%, puis se stabiliser aux alentours de 10%.

Bref, les signes se multiplient, mais les voies de la Force restent encore impénétrables, heureusement peut-être plus pour longtemps ! (Source : GamersNexus)

| Un poil avant ?Mini-ITX en X470, devinez qui sera sur le coup ? | Un peu plus tard ...Les HoloLens 2 en préparation chez Microsoft |  |