NVIDIA met en ligne son livre blanc sur le GP100 Pascal (Hot Pics inside) |

• 21 Avril 2016 à 12h48 • 12778 vues

NVIDIA met en ligne son livre blanc sur le GP100 Pascal (Hot Pics inside) |

• 21 Avril 2016 à 12h48 • 12778 vues

Au début du mois d'avril, on a enfin pu poser les yeux sur une puce Pascal gravée en 16nm FinFET. C'est avec la Tesla P100 (destinée aux serveurs) qu'on a pu avoir quelques informations sur le GP100 qui l'anime. La carte Tesla s'équipe d'un GP100 avec 56 Steaming Multirocessors (SM) actifs sur les 60 disponibles et dans son livre blanc (whitepaper) le caméléon détaille la chose.

![Même pas cap' de cliquer NVIDIA GP100 [cliquer pour agrandir]](/images/stories/_cg/pascal/nvidia-gp100-schema_t.jpg)

Le GP100, ça sera au total 6 Graphic Processing Clusters (GPC), 60 SM (10 par GPC) et 30 Texture Processing Clusters (TPC, contenant chacun 2 SM) et 8 contrôleurs mémoire de 512-bit, pour un total de 4096 bits. Chaque SM a 64 coeurs CUDA, pour un total de 3840 coeurs CUDA (en Single Precision, FP32) et 240 TMU. Chaque contrôleur mémoire est rattaché à 512ko de cache L2 et chaque pile de HBM2 est contrôlée par deux contrôleurs mémoire. Le GPU comprendra donc au total 4096ko de cache L2. L'image précédente n'étant pas très lisible, voici le détail d'un SM.

En passant de la gravure 28nm au 16nm FinFET, NVIDIA a trouvé de la place pour des unités de calcul en double précision. Avec 64 coeurs FP32 par SM, on compte aussi 32 coeurs FP64 (Double Precision), soit un ratio de 2:1 qui va plus loin que le 3:1 de Kepler et fait oublier le 32:1 de Maxwell. On a donc un maximum de 1920 coeurs FP64 une fois les 60 SM du GP100 activés. En plus de profiter d'une gravure plus fine, le GP100 est aussi le premier GPU équipé de la deuxième version de la High Bandwith Memory (HBM2), cette nouvelle technologie de VRAM qui a fait le bonheur des possesseurs de R9 Fury dans sa première version.

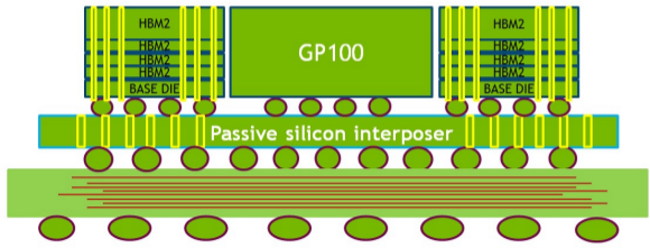

Comme pour les cartes de chez AMD, on trouve un interposer et des piles de VRAM (HBM2 pour le GP100) de part et d'autre. Contrairement à la HBM première du nom qui ne permettait qu'un empilement maximum de quatre couches, la HBM2 permet d'en mettre deux, quatre ou huit. Sur le GP100, nous sommes sur des piles de quatre couches pour une valeur totale de 8Gb, contre des piles de 2Gb pour la HBM. La bande passante par empilement de la HBM était de 125Go/s et passe à 180Go/s sur le GP100. Avec ses 16Go de HBM2 sur interface mémoire 4096-bit, l'engin présente indéniablement un gros plus par rapport à l'actuel standard, la GDDR5. Reste maintenant à voir ce que NVIDIA nous réserve, puisque ce GP100 restera du côté des serveurs et que les GPU destinés au grand public sont prévus pour être bien différents. (source : VideoCardz)

| Un poil avant ?M. Cetelem est de retour avec l'ASUS ROG GT51CA | Un peu plus tard ...AMD clarifie ses plans GPU pour 2016-2018 |  |